Introduction au CI/CD

ENSG Novembre 2024

- Presentation disponible a l’adresse: https://cicd-lectures.github.io/novembre-2024/

- This work is licensed under a Creative Commons Attribution 4.0 International License

Comment utiliser cette présentation ?

- Pour naviguer, utilisez les flèches en bas à droite (ou celles de votre clavier)

- Gauche/Droite: changer de chapitre

- Haut/Bas: naviguer dans un chapitre

- Pour avoir une vue globale : utilisez la touche “o” (pour “Overview”)

- Pour voir les notes de l’auteur : utilisez la touche “s” (pour “Speaker notes”)

Bonjour !

Julien Levesy

Et vous?

A propos du cours

- Alternance de théorie et de pratique pour être le plus interactif possible

- Reproductible à la maison, pensé dans le contexte du “Covid à la maison”

- Contenu entièrement libre et open-source.

- Le code source est visible ici

- Le cours va donner lieu a un projet en guise d’evaluation.

- Les details vous seront donnés en fin de cours.

Avant de Commencer…

- Comment souhaitez vous gérer les pauses midi?

La Petite histoire du Genie Logiciel

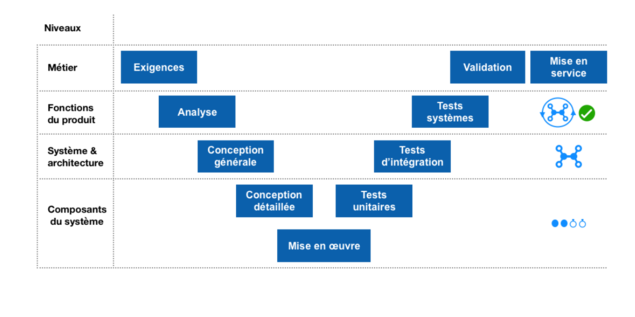

Avant : le cycle en V

Pourquoi questionner le Cycle en V?

- 🤔 On spécifie et l’on engage un volume conséquent de travail sur de simples hypothèses

- … et si les hypothèses sont fausses?

- … et si les besoins changent?

- ⏲️ Cycle très long (6 mois? 1 an?)

- Aucune validation à court terme

- Coût de l’erreur décuplé 💸

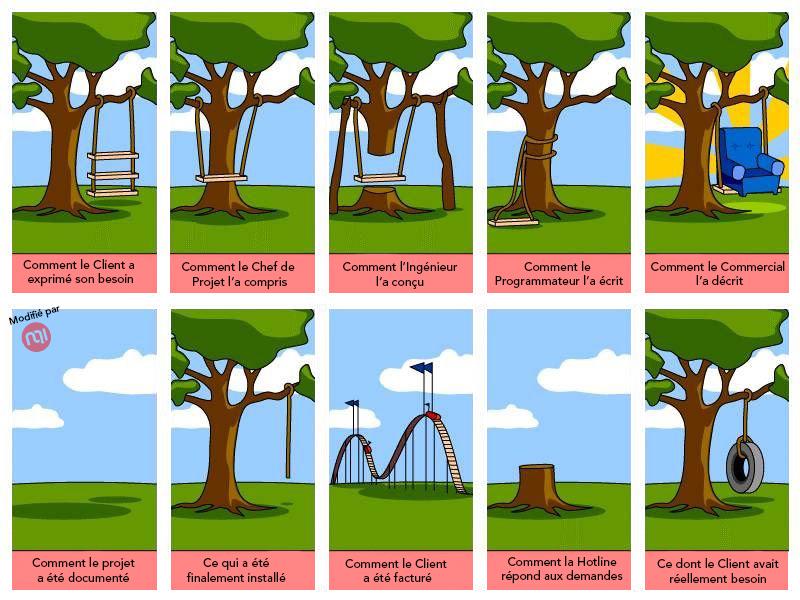

Comment éviter ça?

- Valider les hypothèses au plus tôt, et étendre petit à petit le périmètre fonctionnel.

- Réduire le périmètre fonctionnel au minimum.

- Confronter le logiciel au plus tôt aux utilisateurs.

- Refaire des hypothèses basées sur ce que l’on à appris, et recommencer!

- Faire du changement la norme

- Votre logiciel va changer en continu

La clé : gérer le changement!

- Le changement ne doit pas être un événement, ça doit être la norme.

- Notre objectif : minimiser le coût du changement.

- Faire en sorte que:

- Changer quelque chose soit facile

- Changer quelque chose soit rapide

- Changer quelque chose ne casse pas tout

Le but de ce cours est de vous former aux pratiques d’Integration Continue (CI) et de Livraison Continue (CD) visant a garantir la robustesse et la pérénité d’un produit logiciel face au changement.

Préparer votre environnement de travail

Outils Nécessaires 🛠

GitPod

GitPod.io : Environnement de développement dans le ☁️ “nuage”

- But: reproductible

- Puissance de calcul sur un serveur distant

- Éditeur de code VSCode dans le navigateur

- Gratuit pour 10h par mois (⚠️ jusqu’en Avril 2025…)

- Open-Source : vous pouvez l’héberger chez vous

Démarrer avec GitPod (1/2)🚀

- Rendez vous sur https://gitpod.io/login"

- Authentifiez vous en utilisant votre compte GitHub

- Continuez avec 10h

- Selectionnez

VS Code Browsercomme éditeur - Repondez comme vous le souhaitez aux questions

- Vous devriez atterir sur https://gitpod.io/workspaces

⚠️ Ne vous authentifiez pas sur Gitpod Flex (https://app.gitpod.io) ⚠️

Démarrer avec GitPod (2/2)🚀

- Pour les besoins de ce cours, vous devez autoriser GitPod à pouvoir effectuer certaines modification dans vos dépôts GitHub

- Rendez-vous sur La page des intégrations avvec GitPod

- Éditez les permissions de la ligne “GitHub” (les 3 petits points à droits) et sélectionnez uniquement :

user:emailpublic_repoworkflow

💡Mais qu’est ce qu’un Workspace?

- C’est un ordinateur distant sur lequel on se connecte via le navigateur

- ⚠ Faites attention à réutiliser le même workspace tout au long de ce cours⚠

⚠️ 10h c’est pas beaucoup 😭En fait c’est 50h par défaut- ➡️ Suspendez le workspace GitPod des que vous ne l’utilisez pas

- Bouton bleu en bas a gauche, sélectionnez “Suspend”

Démarrer votre premier Workspace

Cliquez sur le bouton ci-dessous pour démarrer un environnement GitPod personnalisé:

Après quelques secondes (minutes?), vous avez accès à l’environnement:

- Gauche: navigateur de fichiers (“Workspace”)

- Haut: éditeur de texte (“Get Started”)

- Bas: Terminal interactif

- À droite en bas: plein de popups à ignorer

Checkpoint 🎯

Vous devriez pouvoir taper la commande

whoamidans le terminal de GitPod:- Retour attendu:

gitpod

- Retour attendu:

Vous devriez pouvoir fermer le fichier “Get Started”…

- … et ouvrir le fichier

.gitpod.yml

- … et ouvrir le fichier

On peut commencer !

Guide de survie en ligne de commande sous Linux

Remise à niveau / Rappels

CLI?

- 🇬🇧 CLI == “Command Line Interface”

- 🇫🇷 “Interface de Ligne de Commande”

C’est un programme qui accepte une commande en entrée et retourne un resultat.

Nous allons utiliser bash

Anatomie d’une commande

ls --color=always -l /bin

- Séparateur : l’espace

- Premier élément (

ls) : c’est la commande - Les éléments commençant par un tiret

-sont des “options” et/ou drapeaux (“flags”)- “Option” == “Optionnel”

- Les autres éléments sont des arguments (

/bin)- Nécessaire (par opposition)

Manuel des commandes

man <commande> # Commande 'man' avec comme argument le nom de ladite commande

- Navigation avec les flèches haut et bas

- Tapez

/puis une chaîne de texte pour chercher - Touche

npour sauter d’occurrence en occurrence - Touche

qpour quitter

🎓 Essayez avec ls, cherchez le mot color

- 💡 La majorité des commandes fournit également une option (

--help), un flag (-h) ou un argument (help) - … en dernier recours Google c’est pratique aussi !

Raccourcis

Dans un terminal Unix/Linux/WSL :

CTRL + C: Annuler le processus ou prompt en coursCTRL + L: Nettoyer le terminalCTRL + A: Positionner le curseur au début de la ligneCTRL + E: Positionner le curseur à la fin de la ligneCTRL + R + mot clé: Rechercher dans l’historique de commandesTab: Compléter la commande

🎓 Essayez-les ! (Notamment CTRL + R et Tab)

Commandes de base 1/2

pwd: Afficher le répertoire courant- 🎓 Option

-P?

- 🎓 Option

ls: Lister le contenu du répertoire courant- 🎓 Options

-aet-l?

- 🎓 Options

cd: Changer de répertoire- 🎓 Sans argument : que se passe t’il ?

cat: Afficher le contenu d’un fichier- 🎓 Essayez avec plusieurs arguments

mkdir: créer un répertoire- 🎓 Option

-p?

- 🎓 Option

Commandes de base 2/2

echo: Afficher un (des) message(s)rm: Supprimer un fichier ou dossiertouch: Créer un fichiergrep: Chercher un motif de textecode: Ouvre le fichier dans l’éditeur de texte

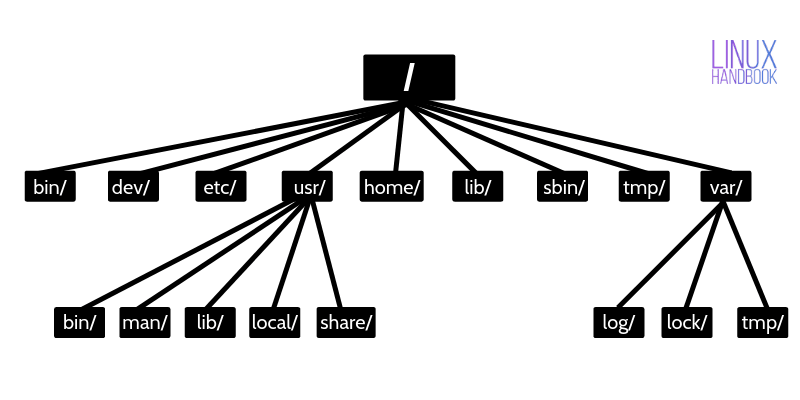

Arborescence de fichiers

- Le système de fichier a une structure d’arbre

- La racine du disque dur c’est

/- 🎓

ls -l /

- 🎓

- Le séparateur c’est également

/- 🎓

ls -l /usr/bin

- 🎓

- La racine du disque dur c’est

Chemins de l’arborescense

- Pour référencer un endroit dans l’arbre, on utilise un chemin

- Deux types de chemins :

- Absolu (depuis la racine): Commence par

/(Ex./usr/bin) - Sinon c’est relatif (e.g. depuis le dossier courant) (Ex

./binoulocal/bin/)

- Absolu (depuis la racine): Commence par

- Le dossier “courant” c’est

.- 🎓

ls -l ./bin # Dans le dossier /usr

- 🎓

- Le dossier “parent” c’est

..- 🎓

ls -l ../ # Dans le dossier /usr

- 🎓

- Tout programme possède un répertoire courant.

- Le Current / Process Working Directory (CWD/PWD)

- On peut changer le répertoire courant de l’interpréteur de commande avec

cd(change directory)

cd /usr/bin # Change le repertoire courant par /usr/bin : on se déplace dans l'arbre

🎓 Dans quel repertoire nous emmène cette succession de commandes?

cd /usr/bin

cd ../..

cd ./workspaces

~(tilde) c’est un raccourci vers le dossier “home” de l’utilisateur courant- 🎓

ls -l ~

- 🎓

-(minus) raccourci pour revenir au dernier répertoire visité (cd -)

Toutes les commandes sont sensible à la casse (majuscules/minuscules) et aux espaces

ls -l /bin

ls -l /Bin

mkdir ~/"Accent tué"

ls -d ~/Accent\ tué

ls -d ~/accent\ tue

Un language (?)

- Support des variables

# On déclare et initialise une variable

MA_VARIABLE="Salut tout le monde"

# On l'évalue avec avec le caractère `$`

echo "${MA_VARIABLE}"

- Evaluation d’une sous commande

echo ">> Contenu de /tmp :\n$(ls /tmp)"

- Des

if, desforet plein d’autres trucs (doc)

Codes de sortie

- Chaque exécution de commande renvoie un code de retour (🇬🇧 “exit code”)

- Nombre entier entre 0 et 255 (en POSIX )

- Ce code indique si la commande s’exécutée avec succes ou non

- Code accessible dans la variable éphémère

$?:

ls /tmp

echo $?

ls /do_not_exist

echo $?

# Une seconde fois. Que se passe-t'il ?

echo $?

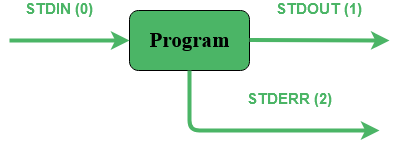

Entrée, sortie standard et sortie d’erreur

- Un programme peut consommer des données sur son entrée standard

stdin(fd=0) - Un programme peut genérer des données sur sa sortie standard

stdout(fd=1) - Ou en cas d’erreur données sur sa sortie d’erreur

stderr(fd=2)

Ces flux de données peuvent être manipulés par l’interpréteur

# Redirige stdout dans un fichier hello.txt

echo "Hello" > /tmp/hello.txt

# Redirige stdout dans le fichier /dev/null

ls -l /tmp >/dev/null

ls -l /tmp 1>/dev/null

ls -l /do_not_exist

# Redirige stdout dans le fichier /dev/null

ls -l /do_not_exist 1>/dev/null

# Redirige stderr dans le fichier /dev/null

ls -l /do_not_exist 2>/dev/null

ls -l /tmp /do_not_exist

# Redirige stdout vers /dev/null et stderr vers stdout /dev/null

ls -l /tmp /do_not_exist 1>/dev/null 2>&1

Pipes

Le caractère “pipe”

|permet de chaîner des commandes- Le “stdout” de la première commande est branchée sur le “stdin” de la seconde

Exemple : Afficher les fichiers/dossiers contenant le lettre

ddans le dossier/bin:

ls -l /bin

ls -l /bin | grep "d" --color=auto

Exécution de programmes

- Les commandes sont des fichier binaires exécutables

- Fichier se trouvant dans l’arborescense de fichier du système

- Pourtant nous indiquons pas de chemin quand on appelle une commande?

🤔 Comment l’interpréteur retrouve quel fichier exécuter a partir d’un simple nom?

- La variable d’environnement

$PATHliste les dossiers dans lesquels chercher les binaires - L’interpréteur cheche le premier binaire qui porte le nom dans les répertoires contenus dans PATH

echo "${PATH}" # Affiche la valeur de PATH

command -v cat # équivalent de "which cat"

ls -l "$(command -v cat)"

💡 Penser a Vérifier cette variable quand une commande fraîchement installée n’est pas trouvée

Checkpoint 🎯

Nous avons vu:

- Le fonctionnement de l’interpréteur de commande

bash - Les raccourcis utiles (

CTRL+RetTAB) - Comment sont organisés les fichiers sous Linux

- Comment manipuler les flux de données entre commandes

Comment fonctionnent les Internets?

🧐 Que se passe-t-il quand je tape google.com dans mon navigateur et que j’appuie sur entrée?

- 📖 Resolution DNS

- 🔌 Connection TCP

- 🔒 Handshake TLS

- ➡️ Envoi d’une requête HTTP au Serveur

- ⬅️ Réception d’une reponse HTTP et décodage du contenu HTML

- 🎨 Rendu de la page par le navigateur

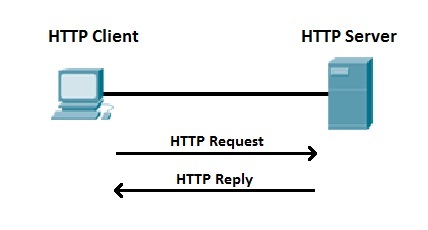

Zoom sur HTTP

- Hyper Text Transfer Protocol

- Défini un format de requête/réponse dans le modèle client / serveur

- ➡️ Le client demande une ressource à un serveur via une requête HTTP,

- ⬅️ Le serveur lui réponds une réponse avec le contenu de la ressource.

Anatomie d’une requête HTTP

Une requête est composée des champs suivant:

- Méthode: Indique une action désirée (

GET,POST,PUT,DELETE,HEAD,OPTIONS…) - Hote: indique un domaine dans lequel récupérer les resources (

github.com) - Chemin (path): indique une ressource à obtenir au serveur (

/assets/file.js) - Paramètres de requête (query parameters): paramètres additionnels de requête apposés au path (

/pages/node?utm_source=facebook) - Entêtes (headers): Couple clé -> multiples valeurs indiquant des méta information sur la requête (

Accepted-Content,User-Agent,Accept,Referrer,Authorization,Cookies) - Corps (body): Optionnel, contenu encodé à envoyer au serveur, par exemple une soumission de formulaires.

Une réponse est composée des champs suivant:

- D’un status code

🐱

- 200 OK, 404 Not Found, 301 Moved Permanently etc..

- Entêtes (headers): Couple clé -> multiples valeurs indiquant des méta information sur la réponse (

Content-Length,Content-Encoding,Content-Type…) - Un corps de réponse à lire et à décoder

- HTML, JSON ou autre…

Comment parler HTTP depuis le terminal?

- On propose d’utiliser cURL

- Outil pour transférer des données dans différents protocoles

- Le couteau suisse des internets!

🎓 Exercice: Première Requête en utilisant cURL

- Que signifie cette ligne de commande?

- Indice:

man curl

- Indice:

- Pouvez expliquer le résultat affiché?

curl --verbose --location --output /dev/null voi.com

✅ Solution: Première Requête en utilisant cURL

- C’est verbeux 🙃, mais on l’a demandé avec

--verbose. cURL va afficher sur la sortie standard tous les échanges effectués avec le serveur --locationindique à cURL de suivre les redirections--outputindique à cURL d’écrire le contenu dans répondu/dev/nullau lieu de l’afficher sur la sortie standard

Regardons d’un peu plus près les logs:

# On se connecte a une IPv6... probablement celle de voi.com?

* Trying [2606:4700:20::681a:3d6]:80...

* Connected to voi.com (2606:4700:20::681a:3d6) port 80

# cURL formule la requête demandée sur HTTP.

> GET / HTTP/1.1

> Host: voi.com

> User-Agent: curl/8.4.0

> Accept: */*

>

# Le serveur nous réponds une 301 !? voi.com à bougé?

< HTTP/1.1 301 Moved Permanently

# [...]

# Aha! Le serveur nous redirige vers le même site, mais en HTTPS sur le port 443.

< Location: https://voi.com:443/

# Comme indiqué: on se reconnecte a voi.com sur le port 443!

* Clear auth, redirects to port from 80 to 443

* Issue another request to this URL: 'https://voi.com:443/'

* Trying [2606:4700:20::681a:3d6]:443...

* Connected to voi.com (2606:4700:20::681a:3d6) port 443

# On se connecte en HTTPS, du coup il va falloir établir une session TLS

# Ensuite cURL et le serveur se mettent d'accord et établissent la connexion sécurisée.

* (304) (OUT), TLS handshake, Client hello (1):

# [...]

# On est connectés de façon sécurisée au serveur!

* SSL connection using TLSv1.3 / AEAD-CHACHA20-POLY1305-SHA256

* Server certificate:

# [...] Le certificat du serveur est valide!

* SSL certificate verify ok.

# [...] On refait notre requête une fois connectés!

> GET / HTTP/2

> Host: voi.com

> User-Agent: curl/8.4.0

> Accept: */*

>

# Victoire le serveur nous réponds!

< HTTP/2 200

# Du HTML!

< content-type: text/html; charset=utf-8

# et 22kb de données!

{ [21877 bytes data]

- Ce qu’il viens de se passer est ce que l’on appelle une

HTTPSupgrade - Le serveur “force” le client a se connecter en utilisant

HTTPSde façon sécurisée! - Pourquoi?

- TLS prouve que le client parle bien au bon serveur!

- TLS chiffre les communications sur le réseau, on peut faire transiter des données sans(trop) se soucier d’être espionnés 🕵️

- Maintenant essayez d’enlever l’option

--location, que se passe-t-il? - Maintenant essayez d’enlever l’option

--output /dev/null, que se passe-t-il?

Autres Options Utiles de cURL

- Contrôle de la méthode de la requête:

--request POST,--request DELETE - Ajouter un header a la requête:

--header "Content-Type: application/json" - Envoyer un body dans la requête:

- Directement depuis la ligne de commande

--data '{"some":"json"}' - En lisant un ficher

--data '@some/local/file'

- Directement depuis la ligne de commande

🎓 Exercice: Afficher du JSON de Façon Lisible

- Qu’affiche le résultat de la commande suivante?

- Comment le rendre plus lisible?

- Indice: il faut utilser un

|(pipe) et la commandejq

- Indice: il faut utilser un

curl https://swapi.dev/api/planets/1

✅ Solution: Afficher du JSON de Façon Lisible

curl https://swapi.dev/api/planets/1 | jq .

Bonus: jq permets de sélectionner un attribut JSON.

curl https://swapi.dev/api/planets/1 | jq .residents

Checkpoint 🎯

- Internet repose sur une collection de protocole (DNS, TCP, TLS, HTTP)

- HTTP permets de formuler une requête à un serveur et une réponse

cURLest un outil très complet pour parler HTTP depuis un terminal!

Les fondamentaux de git

Tracer le changement dans le code

avec un VCS : 🇬🇧 Version Control System

également connu sous le nom de SCM (🇬🇧 Source Code Management)

Pourquoi un VCS ?

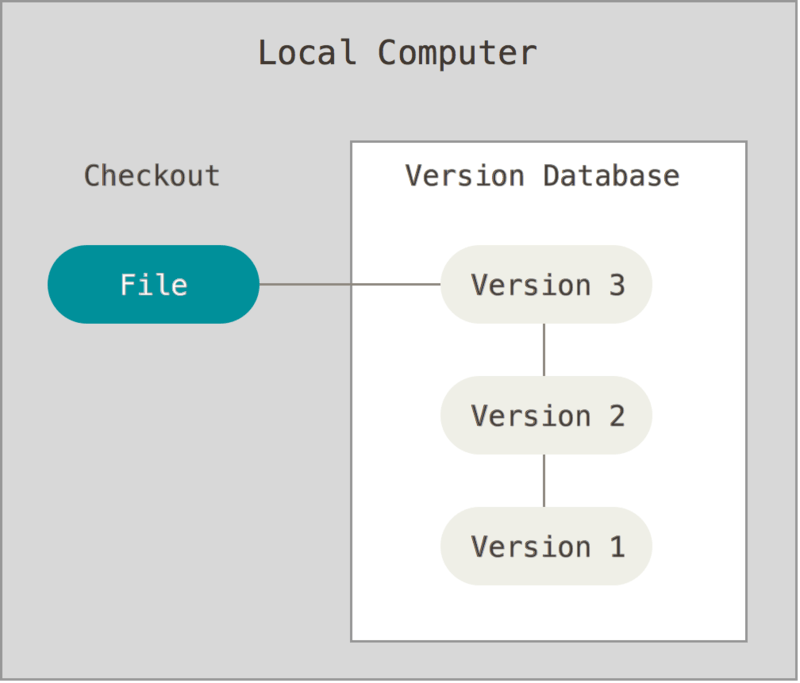

- Le code c’est une collection de fichiers textes dans un repertoire

- … il suffit de sauvegarder ce répertoire pour etre tranquille

Pourquoi encore un outil ?

- Pour conserver une trace de tous les changements dans un historique

- Avoir un historique des changements effectués

- Possibilité de revenir en arrière dans les changements!

- Pour collaborer efficacement sur une même base de code

- Gere l’integration de changements dans l’historique

- Aide à la résolution de conflits

- Simplifie le partage d’une base de code

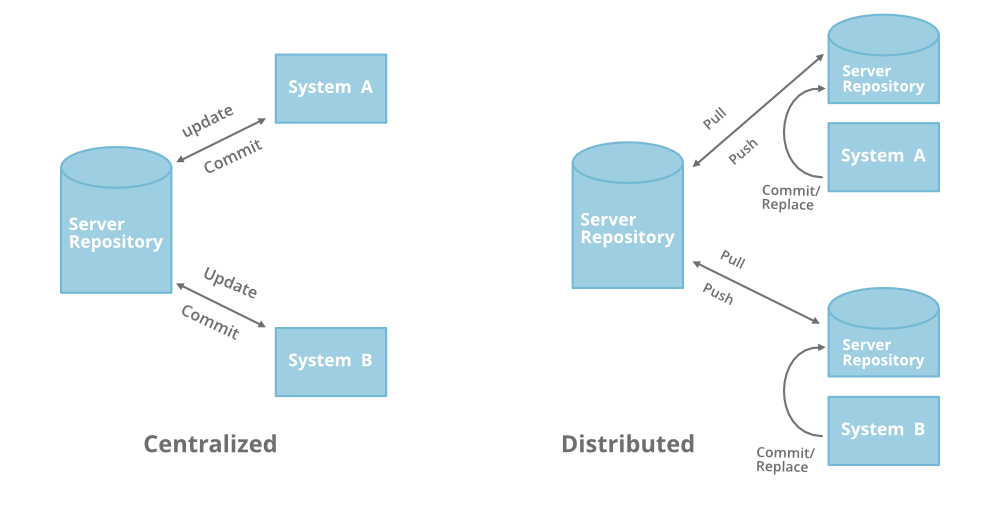

Usage d’un VCS

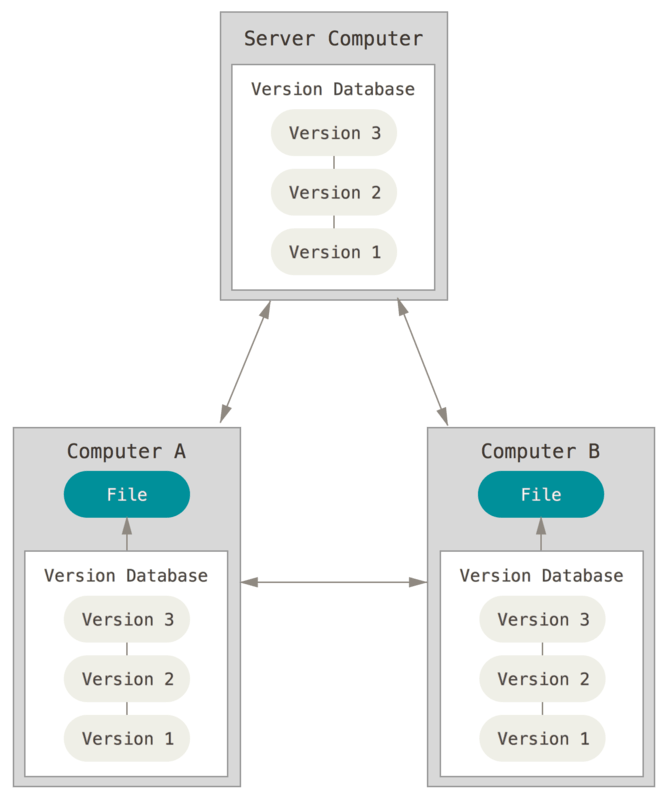

Local

Distribué

Quel VCS utiliser ?

Nous allons utiliser Git

- Git nous permets de transformer notre répertoire en dépôt

- Nous allons pouvoir ensuite ajouter des fichier au dépôt

- …et ensuite les changer!

🎓 Exercice : Intitialiser un dépôt Git

- Dans le terminal de votre environnement GitPod:

- Créez un dossier vide nommé

projet-vcs-1dans le répertoire/workspace, puis positionnez-vous dans ce dossier

mkdir -p /workspace/projet-vcs-1/

cd /workspace/projet-vcs-1/

Est-ce qu’il y a un dossier

.git/?Essayez la commande

git status?Initialisez le dépôt git avec

git init- Est-ce qu’il y a un dossier

.git/? - Essayez la commande

git status?

- Est-ce qu’il y a un dossier

✅ Solution : Intitialiser un dépôt Git

mkdir -p /workspace/projet-vcs-1/

cd /workspace/projet-vcs-1/

ls -la # Pas de dossier .git

git status # Erreur "fatal: not a git repository"

git init ./

ls -la # On a un dossier .git

git status # Succès avec un message "On branch master No commits yet"

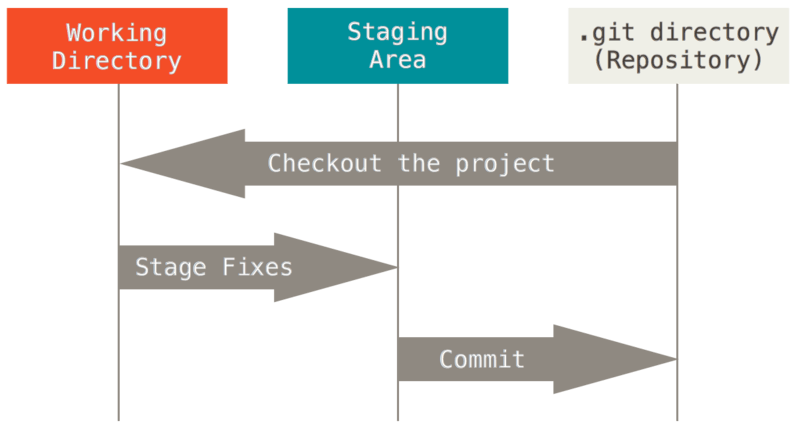

Les 3 états d’un fichier dans un dépôt Git

- L’historique (“Version Database”) : dossier

.git - Dossier de votre projet (“Working Directory”) - Commande

- La zone d’index (“Staging Area”)

🎓 Exercice : Ajouter un fichier

- Créez un fichier

README.mddedans avec un titre et vos nom et prénoms- Essayez la commande

git status?

- Essayez la commande

- Ajoutez le fichier à la zone d’indexation à l’aide de la commande

git add (...)- Essayez la commande

git status?

- Essayez la commande

- Créez un commit qui ajoute le fichier

README.mdavec un message, à l’aide de la commandegit commit -m <message>- Essayez la commande

git status?

- Essayez la commande

🎓 Solution : Ajouter un fichier

echo "# Read Me\n\nObi Wan" > ./README.md

git status # Message "Untracked file"

git add ./README.md

git status # Message "Changes to be committed"

git commit -m "Ajout du README au projet"

git status # Message "nothing to commit, working tree clean"

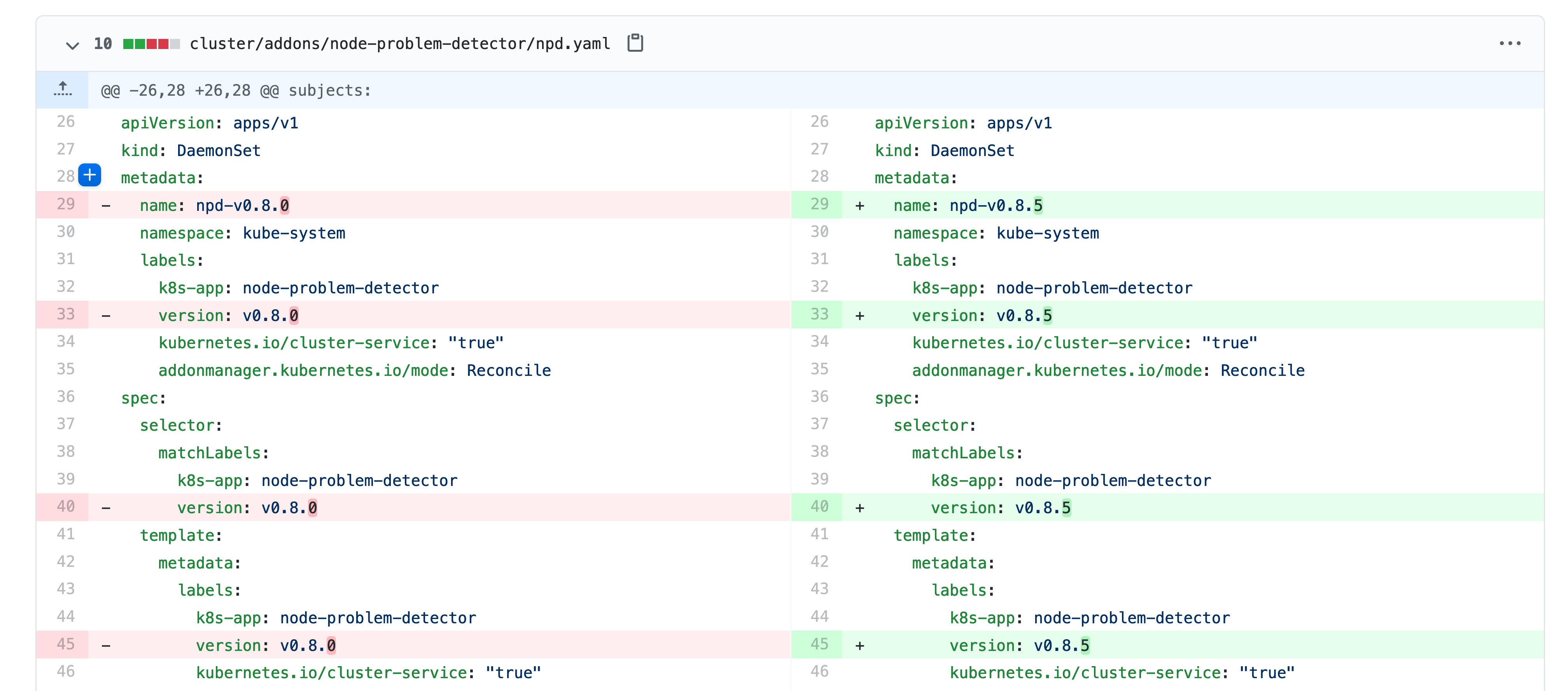

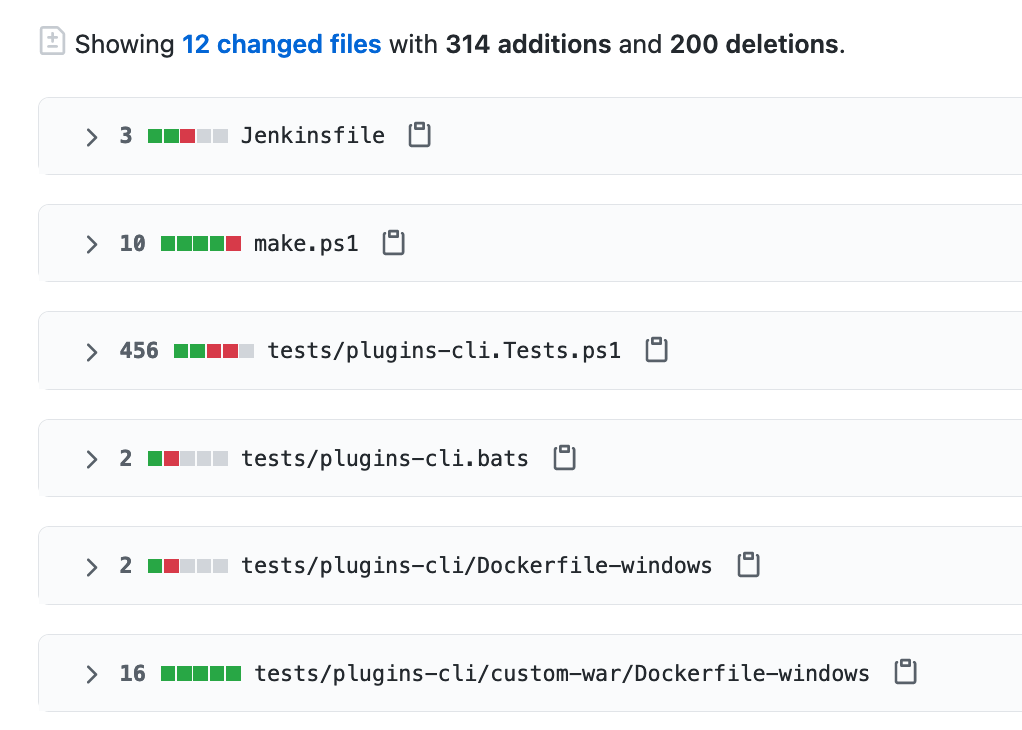

Terminologie de Git - Diff et changeset

diff: un ensemble de lignes “changées” sur un fichier donné

changeset: un ensemble de “diff” (donc peut couvrir plusieurs fichiers)

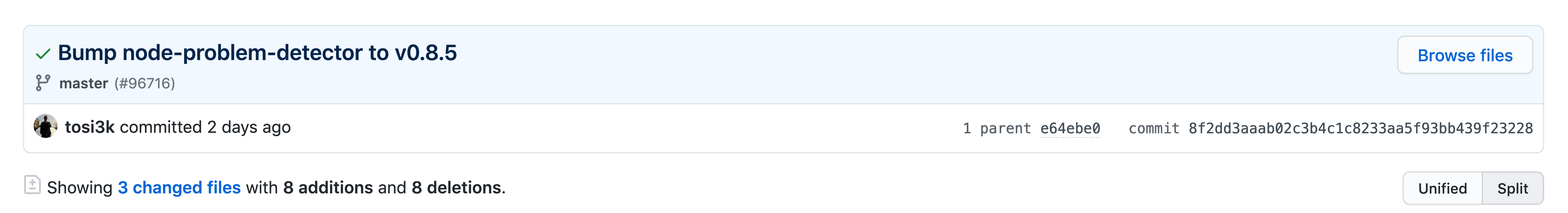

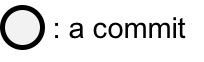

Terminologie de Git - Commit

commit: un changeset qui possède un (commit) parent, associé à un message

“HEAD”: C’est le dernier commit dans l’historique

🎓 Exercice :avec Git - 2

- Afficher la liste des commits

- Afficher le changeset associé à un commit

- Modifier du contenu dans

README.mdet afficher le diff - Annulez ce changement sur

README.md

✅ Solution : avec Git - 2

git log

git show # Show the "HEAD" commit

echo "# Read Me\n\nObi Wan Kenobi" > ./README.md

git diff

git status

git restore README.md

git status

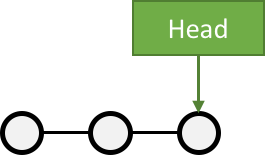

Terminologie de Git - Branche

- Abstraction d’une version “isolée” du code

- Concrètement, une branche est un alias pointant vers un “commit”

🎓 Exercice :avec Git - 3

- Créer une branche nommée

feature/html - Ajouter un nouveau commit contenant un nouveau fichier

index.htmlsur cette branche - Afficher le graphe correspondant à cette branche avec

git log --graph

✅ Solution : avec Git - 3

git branch feature/html && git switch feature/html

# Ou git switch --create feature/html

echo '<h1>Hello</h1>' > ./index.html

git add ./index.html && git commit --message="Ajout d'une page HTML par défaut" # -m / --message

git log

git log --graph

git lg # cat ~/.gitconfig => regardez la section section [alias], cette commande est déjà définie!

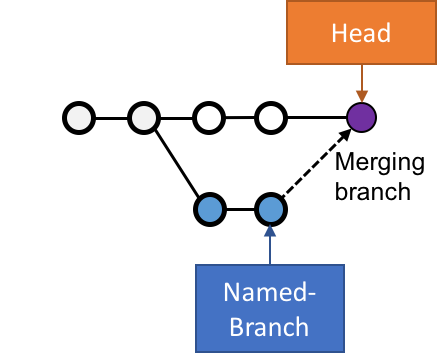

Terminologie de Git - Merge

- On intègre une branche dans une autre en effectuant un merge

- Plusieurs strategies sont possibles pour merger:

- Quand l’historique de commit n’a pas diverge: git fait avancer la branche directement, c’est un fast-forward

- Dans le cas contraire, un nouveau commit est créé, fruit de la combinaison de 2 autres commits

🎓 Exercice :avec Git - 4

- Merger la branche

feature/htmldans la branche principale- ⚠️ Pensez à utiliser l’option

--no-ff(no fast forward) pour forcer git a créer un commit de merge.

- ⚠️ Pensez à utiliser l’option

- Afficher le graphe correspondant à cette branche avec

git log --graph

✅ Solution : avec Git - 4

git switch main

git merge --no-ff feature/html # Enregistrer puis fermer le fichier 'MERGE_MSG' qui a été ouvert

git log --graph

# git lg

Exemple d’usages de VCS

“Infrastructure as Code” :

- Besoins de traçabilité, de définition explicite et de gestion de conflits

- Collaboration requise pour chaque changement (revue, responsabilités)

Code Civil:

🎯 Checkpoint

On a vu :

- A quoi sert

gitet sa nomenclature de base (diff, changest, commit, branch) - A quoi reconnaître un dépôt initialisé local et l’espace de travail associé

- Comment utiliser git localement (ajouter au staging, commiter)

- l’historique et un merge avec git (localement)

Javascript et NodeJS

Javascript

- Langage interprété, syntaxe proche du C

- Typage dynamique (types des variables assigné // deviné á l’exécution)

- Gestion de la mémoire automatisée (avec un Garbage Collector)

- Fonctions pouvant être manipulées comme des variables

- Supporte différents styles de programation (impératif, OO ou fonctionnel)

- Pensé pour l’évenementiel, la concurence

- Standardisé par l’European Computer Manufacturers Association (ECMA)

- Avec la spécification ECMA-262 réévaluée tous les ans depuis 2015.

- Langage de script initialement conçu pour rendre interactives des pages web (AJAX)

- Maintenant aussi utilisé coté serveur!

Ou s’exécute le code Javascript?

Nous avons besoin d’un interpréteur pour exécuter notre code Javascript

NodeJS? Kézako?

- Environement d’exécution Javascript libre et multi platforme

- Basé sur V8

- Possède une vaste librairie standard

- Optimisé pour les opérations asynchrones

- Actuellement en version 23

🎓 Exercice : Un premier programme NodeJS

- Dans le répertoire

workspacecréez un répertoirehelloworld - Dans ce répertoire, créez un fichier

index.jsavec le contenu suivant

console.info("Hello World");

- Exécutez votre programme a l’aide de la commade

node ./index.js - Que se passe t’il?

✅ Solution : Un premier programme NodeJS

# Crée un répertoire helloworld

mkdir -p /workspace/helloworld

# Saute dans le répertoire

cd /workspace/helloworld

# Crée un fichier index.js avec notre programme

echo 'console.info("Hello world");' > index.js

# Exécute notre programme

node ./index.js

Ce programme affiche sur sa sortie standard le message “Hello World”

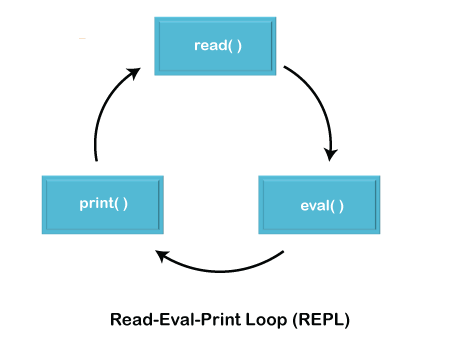

- NodeJS peut exécuter un programme:

node ./monprograme.js - Ou alors s’exécuter en mode REPL:

node- 💡 Très utile pour expérimenter… ou s’en servir de calculatrice :D

🎓 Quel est le résultat de l’opération ((38 + 44) / 12) - 1

Un programme un peu plus complexe

Voici maintenant un programme qui résouds le nom de domaine voi.com vers une adresse IP en utilisant DNS

import dns from 'node:dns';

dns.resolve('voi.com', (err, records) => {

console.log(records, err);

});

- 🎓 Quelle sont les adresses IP du site voi.com?

- 🎓 (bonus) et les addresses IPv6? doc

Analysons ligne par ligne

import 'dns': Importe le modulednsde la librairie standard nodedns.resolve: Appelle la fonctionresolvedu module DNS en passant deux arguments.- Une chaine de caractères ‘voi.com’

- Une fonction anonyme qui accepte deux arguments (err, records) et qui affiche la liste d’adresses

Types en Javacript

Javascript est un langage faiblement typé

let foo = 42; // foo is now a number

foo = "bar"; // foo is now a string

foo = true; // foo is now a boolean

Types primitifs

Boolean: true ou falseNumber: Valeur numérique stockée sur 64 bits (regroupe integer ET float)String: Chaine de caractères (UTF-16)Null: absence d’un object, une seule valeur possiblenullUndefined: absence de valeur, une seule valeur possibleundefined

D’autres types existent … Bigint, Symbol…

null vs undefined

undefinedsignifie qu’une variable a été déclarée mais n’a pas reçu de valeur.nullsignifie l’absence d’objet

let foo;

console.log("FOO", foo) // <- undefined

let bar = null;

console.log("BAR", null) // <- null

Variables en Javascript

- Une variable est une zone mémoire dans laquelle on peut écrire ou lire une valeur

- Il existe trois mots clés pour déclarer des variables

- let: Déclare une variable réassignable

- const: Déclare une variable non réassignable (en lecture seule)

- var: Déclare une variable réassignable

- Maintenue dans la spec pour rétrocompatibilité, mais il est recommandé de ne plus l’utiliser

Différence entre const et let

let foo = 4;

const bar = 12;

foo = 56;

bar = 67;

🎓 Le script suivant s’exécute t’il?

Différences entre var et let/const

Une variable déclarée avec let / const n’est utilisable que si elle est déclarée préalablement.

function good() {

count = 12; // ReferenceError: Cannot access 'count' before initialization

let count = 0;

}

function bad() {

badCount = 42; // Valid, because of some reordering happening when node interprets the code.

var badCount = 12;

}

bad();

good();

La portée d’une variable déclarée avec let ou const est facilement prédictible

var bad = 12;

let good = 42;

if (true) {

var bad = 56;

let good = 12;

}

console.log(bad, good)

🎓 Qu’affiche le script suivant?

Variables en Javascript: bonnes pratiques

- 💀 On n’utilise pas

var. - ✅ Si notre variable n’est pas réécrite, on utilise

const - ✅ Sinon, on utilise

let.

Déclaration de Block

- Tout ce qui est entre accolade est un

block. - La portée des variables déclarées avec

constetletest le “block”

{ // block anonyme

const maVariable = 12;

};

console.log(maVariable);

🎓 Le script suivant s’exécute t’il?

Controle de flot

// if / else

if (condition1) {

statement1;

} else {

statement2;

}

// switch case

const name = "julien"

switch (name) {

case "michel":

//...

case "julien":

console.log("bonjour");

default:

// ...

}

Conditions

Toute expression qui évalue vers une valeur booleenne

a == b // égalité

a === b // égalité stricte

a >= b // comparaisons

❌ a = b // Pas une condition, un assignement!

Egalité vs Egalité stricte

- ❌

a == begalité, tente de faire des conversion de types implicites - ✅

a === bégalité stricte, ne fait pas de conversions implicites

let a = 2;

let b = '2';

a == b; // true

a === b; // false, a est du type number, b est du type string

Boucles

for (let step = 0; step < 5; step++) {

// Runs 5 times, with values of step 0 through 4.

console.log("Walking east one step");

}

Il y à plein d’autres formes de boucles documentation .

Fonctions

- Une fonction est un groupement logique d’instructions

- Accepte des arguments et peut retourner un résultat

function sayHello(name) {

console.log("Hello", name);

}

Passage des arguments par valeur (on fait une copie)

function passageParValeur(count) {

count = 56;

}

let value = 45;

passageParValeur(value);

console.log(value); // <- Affiche 45

…sauf dans le cas des objets!

func makeItAHonda(car) {

car.brand = "honda";

}

const car = {

brand: "renault",

seats: 4

};

console.log("brand is", car.brand); // Affiche renault

makeItAHonda(car);

console.log("brand is", car.brand); // Affiche honda!

Les fonctions peuvent etre manipulées comme des valeurs

function otherFunction(callback) {

// do something...

const result = getResult();

callback(result);

}

const myCallback = function(result) {

console.log("Result is", result);

}

otherFunction(myCallback);

Une fonction à accès aux variables déclarées dans le scope parent.

function sum(a) {

const word = "coucou";

return function(b) {

console.log(word);

return a + b;

};

}

console.log(sum(3)(4));

Cela s’appelle une closure

Arrow Functions

Syntaxe allégée pour déclarer et implémenter une fonction.

function otherFunction(callback) {

// do something...

const result = getResult();

callback(result);

}

const myCallback = (result) => {

console.log(result);

};

otherFunction(myCallback);

otherFunction((result) => console.log(result));

Collections

On distigue deux types:

- Les collections indexées: tableaux

- Les collections clés valeur: les maps

const arr = [1, 2, 3, 4];

const arr1 = new Array(1, 2, 3, 4); // équivalent

const arr2 = Array(1, 2, 3, 4); // équivalent

// Accès par index

console.log(arr[2]);

// Itération

for (v of arr) {

console.log(v);

}

arr.forEach((v) => console.log(v));

🎓 Exercice: Trouvez la valeur la plus grande dans un tableau;

Soit le tableau suivant:

const arr = [18, 4, 99, 1203, 5, 3, 5566, 22, 12];

✅ Solution: Trouvez la valeur la plus grande dans un tableau

function findMax(arr) {

let max = 0;

for value of arr {

if value > max {

max = value;

}

}

return max;

}

// Ou encore...

function findMaxH4ckZ0r(arr) {

return arr.reduce((max, v) => v > max ? v : max)

}

💭 Quelle version préférez vous?

Objets

Un objet est une collection d’attributs.

On peut créer un objet avec une expression litterale

const myCar = {

brand: "Renault",

wheels: 3,

year: 1997

}

Ou encore avec un constructeur

function Car(make, model, year) {

this.make = make;

this.model = model;

this.year = year;

}

const myCar = new Car("renault", 3, 1997);

Accéder aux propriétés d’un objet

const myCar = {

brand: "Renault",

wheels: 3,

year: 1997

}

// Dot notation

console.log("La marque est", myCar.brand);

// Bracket notation

console.log("La marque est", myCar["brand"]);

// Les attributs non définis ont la valeur `undefined`

console.log(myCar.wings) // undefined

Classes

- Depuis ES6 (2015), Javascript supporte l’idée de

classe, comme d’autres langages orientés objet - Une classe c’est:

- Une définition de type

- Qui comporte un état (une collection d’attributs)

- Et des méthodes (des fonctions attachées a ce type)

class Car {

// Attributs privés

#brand = "";

#wheels = 0;

#year = 0;

// Constructeur

constructor(brand, wheels, year) {

this.#brand = brand

this.#wheels = wheels

this.#year = year

}

// Accesseur

get wheels() {

return this.#wheels

}

// Methode

isOperational() {

return this.#wheels === 4;

}

}

On crée une nouvelle instance d’une classe, un objet, avec new

const myCar = new Car("Renault", 3, 1998);

if (myCar.isOperational()) {

console.log("I can drive my car");

} else {

console.log("I can't drive my car");

}

myCar.#wheels // Jette une erreur!

myCar.wheels // Utilise l'accesseur!

Un petit mot au sujet de this

thisest une référence vers l’objet courant dans une méthode- En dehors d’un objet,

thispointe vers “l’objet global” - Pour une fonction la valeur de this est déterminée au moment de l’appel de la fonction

function Car() {

this.honk = function() {

console.log("HONK HONK");

};

setTimeout(function() {

this.honk(); // TypeError: this.honk is not a function WAAAAAAAT?

}, 2000);

}

Ce comportement (peu intuitif) change avec les arrow functions, this est hérité du scope de l’appelant!

function Car() {

this.honk = function() {

console.log("HONK HONK");

};

setTimeout(() => {

this.honk();

}, 2000);

}

Gestion d’erreur

Javascript représente une erreur a l’aide d’exceptions:

- On “jette” une exception a l’aide de l’instruction

throw - On “attrape” une exception avec des instructions

try..catch..finally

function doSomethingButFails() {

throw "oops something went wrong";

}

try {

doSomethingButFails();

} catch (e) {

console.error("Could not do something", e);

} finally {

console.info("Show must go on! Let's proceed anyway!");

}

Interpolation de chaines de caractères

On peut faire de l’interpolation de chaines de caractères en utilisant les backticks

const age = 12;

const message = `Your age is ${age}`;

console.log(message); // Your age is 12

🎓 Exercice: Votre Premier Serveur HTTP avec Node

- Ecrivez un script js qui lance un serveur HTTP de façon a ce que la commande

curlsuivante reçoive en réponse

curl "localhost:3000?name=julien"

Hello julien

- Il faut se servir de la fonction

createServermodule HTTP de node doc - Ne pas oublier de démarer le serveur en appelant

listendoc - Pour extraire le paramètre de requète name il vous faut

- Parser l’URL de la requète aver

const reqUrl = new URL("http://localhost"+req.url) - Et ensuite accéder au paramètre avec

reqUrl.searchParams.get("name")

- Parser l’URL de la requète aver

✅ Solution: Votre Premier Serveur HTTP avec Node

import http from "node:http";

import { URL } from "node:url";

const srv = http.createServer((req, res) => {

const reqUrl = new URL("http://localhost"+req.url);

res.statusCode = 200;

res.end("Hello " + reqUrl.searchParams.get("name")+"\n");

});

srv.listen(3000, "localhost", () => {

console.log("Serving requests...");

});

Modules Javascript

- En JS, un fichier est égal a un module

- Deux standards existent

CommonJS: Venant de l’ecosystème NodeJSMJS: Standardisé par ECMA

Modules Javascript MJS

// moduleA.js

class Car {

// etc...

}

const message = "Hello, from Module A!";

export default message;

export Car;

// moduleB.js

import messageA, { Car } from "./moduleA";

console.log(messageA);

const myCar = new Car()

🎓 Exercice: Déplacez votre serveur HTTP dans un module

- Groupez la logique de votre serveur dans une fonction dédiée

- Déplacez cette fonction dans un nouveau module JS (nouveau fichier) qui exporte cette fonction.

- Importez votre module dans votre script index.js

✅ Solution: Déplacez votre serveur HTTP dans un module

// server.js

import http from "node:http";

import { URL } from "node:url";

export function runServer() {

const srv = http.createServer((req, res) => {

const reqUrl = new URL("http://localhost"+req.url);

res.statusCode = 200;

res.end("Hello " + reqUrl.searchParams.get("name")+"\n");

});

srv.listen(3000, "localhost", () => {

console.log("Serving requests...");

});

}

// index.js

import { runServer } from "./server.js";

runServer();

Javascript Asynchrone

- Ajouez une ligne de log immédiatement après l’appel a votre fonction qui execute le serveur

- Est-ce que cette ligne sera affichée après

Serving requests...ou avant?

// index.js

import { runServer } from "./server.js";

runServer();

console.log("Done with index.js");

Done with index.jsest affichée avant!- Pourquoi?

Server.listenest une opération asynchrone- Cette opération crée un socket et écoute dessus, cela utilise un (ou plusieurs) appels système bloquants

- Problème :

nodejsn’utilise qu’un seul thread, si l’on effectue une opération bloquante de façon synchrone, le reste de notre application ne pourra plus s’exécuter pendant la durée de cette opération! - Solution:

nodejsne bloque pas sur les appels systèmes, mais enregistre le fait qu’il faut appeler une fonction dite callback passée en argument quand l’opération bloquante est terminée!

- Problème :

Différents styles de programation asynchrone:

- 🔴 Callbacks: on passe une ou plusieurs fonction appelées quand l’opération bloquante est terminée

- Simple, mais cela mène rapidement a du code 🍝

- 🟡 Promesses: une fonction bloquante retourne une

promesse. - 🟢 Async/Await: On cache une promesse derrère des mots clefs du langage.

Promesses

Objet qui représente la complétion our l’echec d’une opération asynchrone.

// promesse qui résouds après 500ms!

const promise = new Promise((resolve, reject) => {

setTimeout(() => {

resolve("hello ENSG");

, 500)

});

promise

// On chaine un premier "handler" qui traite le resultat de la promesse et retourne une autre valeur

.then((result) => {

console.log("Result is", result);

return result.length

})

// On chaine un second "handler" qui traite le resultat de la promesse précédente

.then((length) => {

console.log("length is", length)

})

// On chaine un "handler" d'erreur qui traite le cas ou notre promesse échoue

.catch((err) => {

console.error(err);

});

🎓 Exercice: Utilisation de l’API fetch

Fetch est une API native de Javascript qui permets de récupérer une resource en effectuant une requète HTTP doc

- Ecrivez un script JS qui affiche la population de Tatooine en récupérant avec

fetchle contenu à l’URL suivante

https://swapi.dev/api/planets/1

- 💡 Pour parser en JSON le contenu de la réponse HTTP, il faut utiliser la méthode json de la réponse … qui retourne une promesse!

- 💡 Il est possible de voir un aperçu de la réponse JSON ici

✅ Solution: Utilisation de l’API fetch

//index.js

fetch("https://swapi.dev/api/planets/1")

.then((resp) => resp.json())

.then((planet) => {

console.log("planet population is ", planet.population);

});

Bon c’est toujours un peu 🍝🍝🍝🍝🍝🍝

Async / Await

- ECMASript 2017 introduit les fonctions asynchones: fonction déclarée avec le mot clé

async - Une fonction asyncrhone peut porter une ou plusieurs instructions

awaitqui attendent la résolution d’une promesse.

async function doStuff() {

const promise = new Promise((resolve, reject) => {

setTimeout(() => resolve("Hello ENSG"), 500);

})

const result = await promise;

console.log("Result is", result)

console.log("Length is", result.length)

}

doStuff();

🎓 Exercice: fetch avec Async / Await

Réécrivez votre programme qui donne la population de tatooine en utilisant Async / Await

✅ Exercice: fetch avec Async / Await

async function fetchTatooinePopulation() {

const response = await fetch("https://swapi.dev/api/planets/1");

const planet = await response.json();

console.log("planet population is", planet.population);

}

fetchTatooinePopulation();

Checkpoint 🎯

- Nous avons revu les primitives de bases de JS

- Les modules

- Les opérations asynchrones

- Javascript est un langage qui semble seulement facile d’accès…

- … mais qui amène son lot de subtilités!

Références

Typescript

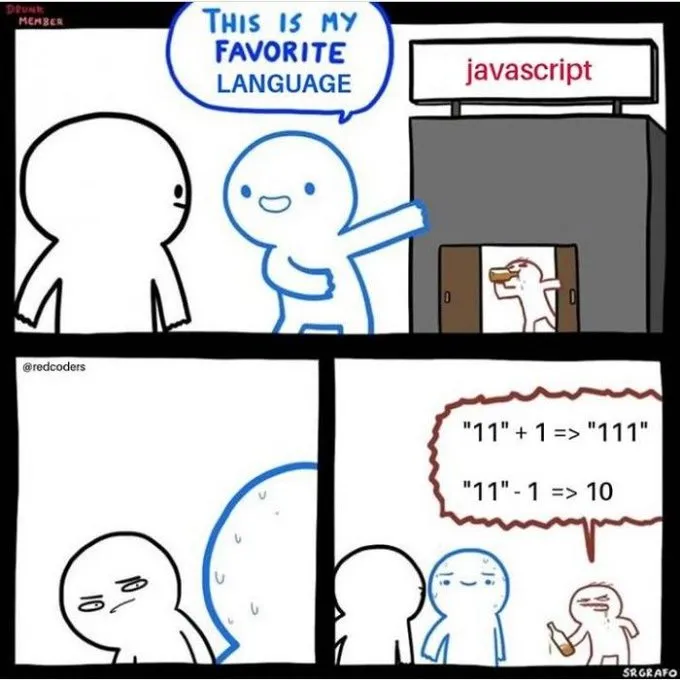

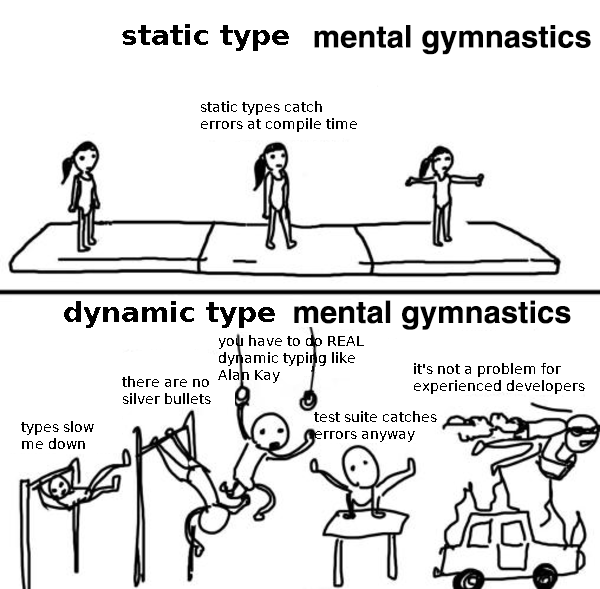

Le typage dynamique, cette fausse bonne idée!

function printLength(item) {

console.log("Length is", item.length);

}

printLength([1,2,3]); // Ok!

printLength("coucou"); // Ok!

printLength({"name":"joel"}); // Ok... oh wait?

Toute une classe d’erreurs (stupides) de programation ne sont détectées qu’a l’exécution, alors qu’on pourrait les trouver bien plus tot!

Erreurs d’autant plus faciles à commettre…

🤯🤯 🤯 Et si on rajoutait un système de typage statique sur Javascript 🤯 🤯 🤯

Hello Typescript

- Langage Open Source dévelopé par Microsoft

- 1.0 en 2014, Actuellement en v5

- Rajoute des annotations optionelles de typage a Javascript

- Superset de Javascript (tout programme Javascript est valide en Typescript)

Un premier programme Typescript

type User = {

name: string;

age: number;

};

function isAdult(user: User): boolean {

return user.age;

}

const justine = {

name: 'Justine',

age: 27,

} satisfies User;

const isJustineAnAdult = isAdult(justine);

🎓 Exécutez ce programme avec node

type User = {

^^^^

SyntaxError: Unexpected identifier 'User'

at wrapSafe (node:internal/modules/cjs/loader:1497:18)

at Module._compile (node:internal/modules/cjs/loader:1519:20)

at Object..js (node:internal/modules/cjs/loader:1709:10)

at Module.load (node:internal/modules/cjs/loader:1315:32)

at Function._load (node:internal/modules/cjs/loader:1125:12)

at TracingChannel.traceSync (node:diagnostics_channel:322:14)

La “““transpilation”””

nodeexécute du Javascript, pas du Typescript- Il faut convertir notre code Typescript en Javascript

- Pour cela on utilise la commande

tsc(Typescript Compiler)

tsc ./index.ts

Visiblement le compilateur Typescript a trouvé quelque chose!

index.ts(7,3): error TS2322: Type 'number' is not assignable to type 'boolean'.

- 💀 C’est un souci de typage qui signifie une erreur de logique!

- Notre fonction

isAdultdevrait comparer l’age de la personne à un age seuil pour dire si elle est adulte ou non!

🎓 Notre programme à un souci, corrigez le!

Types primitifs

string, number, void (rien) and boolean

let age :number = 10;

let age = 10; // Equivalent, tsc devine le type de la variable age en fonction de la valeur assignée!

const isFalse :boolean = false;

const name = "hello word";

age = name; // Type 'string' is not assignable to type 'number'.

Collections

const ages :number[] = [2, 3, 4];

const ages = [2, 3, 4]; // Equivalent

const ages :Array<number> = [2, 3, 4]; // Equivalent, utilise un type parametrique

Any

any est un type spécial qui signifie tous les types. A éviter car on perds l’intérèt d’utiliser typescript

let foo :any = 4;

foo = "string";

foo = {};

Fonctions

On rajoute des annotations aux arguments et à la valeur de retour!

function sayHello(name: string, age: number): void {

console.log(`Hello ${name}, you have ${age} years old`);

}

const sayArrow = (name :string, age :number): void => {

console.log(`Arrow ${name}, you have `${age} years old`);

};

Pour les fonctions anonymes, le type est deviné par le compilateur.

const numbers = [1, 2, 3, 4];

numbers.forEach((v) => console.log(v.length)); // Property 'length' does not exist on type 'number'

Objets

function sayHello(user: { name: string, age: number}): void {

console.log(`Hello ${user.name}, your age is ${user.age}`);

}

type User = {

name: string;

age: number;

};

function sayHelloClean(user :User): void {

console.log(`Hello ${user.name}, your age is ${user.age}`);

}

Définir ses Propres Types

Deux façons plus ou moins équivalentes: alias de types ou interfaces

// Déclare le type user qui est un objet deux attributs (name et age).

type User = {

name: string;

age: number;

};

// Déclare l'interface User2 qui représente l'ensemble des objets ayants au moins l'attribut name et age.

interface User2 {

name: string;

age: number;

}

function sayHello(user: User) {

//...

}

function sayHello2(user: User2) {

// ...

}

const myUser = {name: "John", age: 40};

const myCar = {name: "Bernadette2", age: 4, brand: "McLaren" };

sayHello(myUser); // OK!

sayHello2(myUser); // OK!

sayHello(myCar); // OK!

sayHello2(myCar); // OK!

Attributs Optionels

type User = {

name: string;

age: number;

haircut?: string; // Haircut peut etre soit une string, soit undefined

};

const user: User = {name: "foo", age: 12};

console.log(user.haircut);

user.haircut = "banana"

console.log(user.haircut);

Types Paramétriques

Permets de définir un type en fonciton d’un (ou plusieurs) autre(s).

// Définit une interface Container de quelque chose (type T).

interface Container<T> {

content: T;

}

let intContainer :Container<number> = {content: 4};

let stringContainer :Container<string> = {content: "foooo"};

//Exemple concret: Arrays!

const myArray :Array<string> = ["foo", "bar", "biz"];

Unions

type NumberOrString = number | string;

type StringOrNullOrUndefined = string | null | undefined;

type User = {

name: string;

age: number;

haircut: StringOrNullOrUndefined; // Haircut peut etre soit une string, soit undefined

};

🎓 Exercice: Corrigez le code suivant

Corrigez le code suivant de façon à ce que tsc passe… (sans toucher au corps de la fonction startCar)

type Car = unknown;

function startCar(car: any) {

console.log(`Cheking the wheels ${car.wheels.length}`);

console.log(`Starting the car ${car.brand}`);

}

✅ Solution: Corrigez le code suivant

type Wheel = {};

type Car = {

brand: string;

wheels: Array<Wheel>;

};

function startCar(car: Car) {

console.log(`Cheking the wheels ${car.wheels.length}`);

console.log(`Starting the car ${car.brand}`);

}

Checkpoint 🎯

Nous avons vu comment utiliser Typescript

Nous avons vu rapidement quelques primitives de bases du langage

- Types primitifs et annotations

- Objets

- Définition de types, unions et types generiques

Pour aller plus loin c’est par ici !

Présentation de votre projet

Contexte(1/4)

- Voi est une société qui fournit un service de “véhicules de transport doux” à la demande

- 🔓 Vous déverrouillez un véhicule avec votre Smartphone

- 🛴 Vous faites votre trajet avec le véhicule

- 🔒 Vous verrouillez et laissez le véhicule sur votre lieu d’arrivée

- 💸 Vous payez le temps passé sur le véhicule

Contexte(2/4)

Un cas d’utilisation majeur est de permettre aux utilisateurs de trouver un véhicule proche d’eux facilement.

Contexte(3/4)

- Ce service est assuré par une API HTTP appelée

vehicle-serverqui doit supporter les fonctionnalités suivantes:- Enregistrer un véhicule

- Trouver les N véhicules les plus proches de soi

- Supprimer un véhicule

Contexte (4/4)

- Voi est entrain de reconstruire cette fonctionnalité et à décidé de sous-traiter le développement de ce projet a l’ENSG…

- Une équipe technique de Voi avait commencé l’implémentation du serveur, et vous à mis à disposition une archive ici , contenant le code source du projet.

Prise en Main du Projet

cd /workspace

# Téléchargez le projet sur votre environnement de développement

curl -sSLO https://cicd-lectures.github.io/assets/vehicle-server.tar.gz

# Décompresser et extraire l'archive téléchargée

tar xvzf ./vehicle-server.tar.gz

cd ./vehicle-server

A partir de la vous pouvez ouvrir le fichier README.md et commencer à suivre ses instructions.

Qu’est-ce qui va / ne va pas dans ce projet d’après vous?

Triste Rencontre avec la Réalité

- Pas de gestion de version

node_modulesnous est fourni tel quel, aucun moyen de le reconstruire.- Le projet ne fonctionne pas complètement,

- delete réponds un erreur 😭

- create accepte un shortcode de 6 caractères, et en demande 4!

- On lance le js directement depuis

dist…mais on ne sait pas le générer!

🎓 Exercice : Initialisez un dépôt git

- Supprimez les répertoires

dist,node_moduleset l’archive - Mettez en place un fichier

.gitignorequi vous évitera de comitterdist/etnode_modules!- 💡doc

- Initialisez un dépôt git dans le répertoire

- Créez un premier commit, avec uniquement le code source Typescript

✅ Solution : Initialisez un dépôt git

# Suppression des fichiers générés

rm -f /workspace/vehicle-server.tar.gz

rm -rf ./dist ./node_modules

# Création et édition du fichier .gitignore

code .gitignore

# On initialise un nouveau dépôt git

git init

# On ajoute tous les fichiers contenus a la zone de staging.

git add .

# On crée un nouveau commit

git commit -m "Add initial vehicle-server project files"

Contenu du fichier .gitignore

node_modules/

dist/

Checkpoint 🎯

Vous avez récupéré un projet typescript qui semble fonctionner…

- ..mais pas vraiment à l’état de l’art.

Application des chapitres précédents : vous avez initialisé un projet

gitlocal

Produire un Livrable

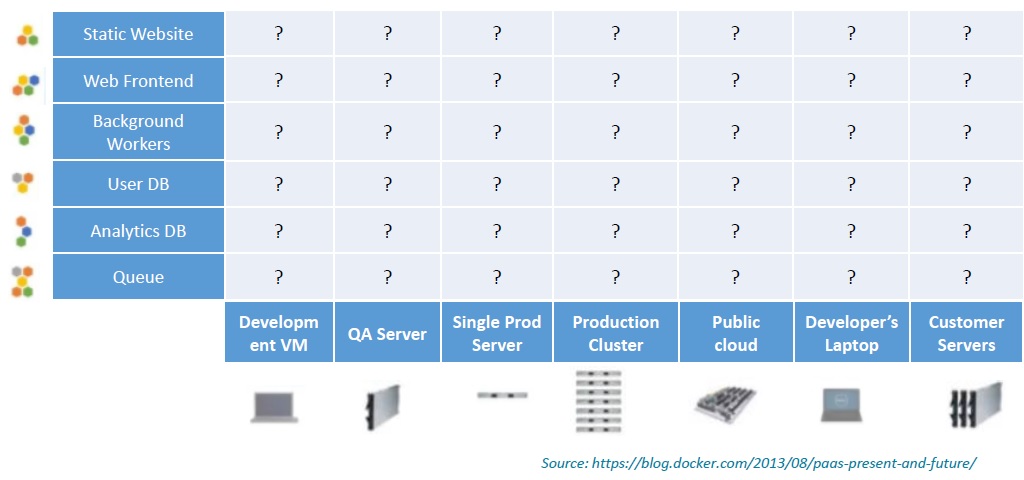

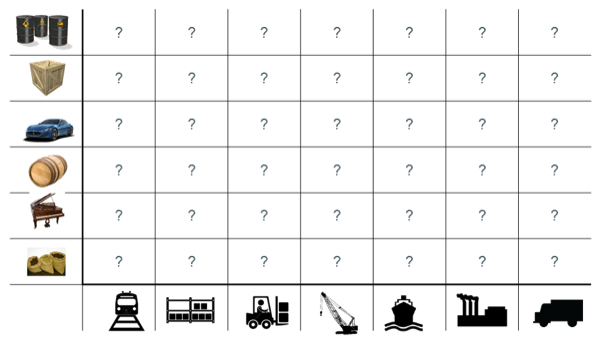

🤔 Quel est le problème ?

On a du code. C’est un bon début. MAIS:

- Le code en lui meme ne délivre pas de valeur,

- C’est l’exécution de ce programme qui en produit!

- Qu’est ce qu’on “fabrique” à partir du code ?

- Un livrable (un binaire, une image Docker, une application iOS // Android …)

Caractéristiques de notre livrable 📦

Nous souhaitons que notre livrable soit:

- Versionné: Chaque livrable est associé a une version de notre base de code

- Reproductible:

- Il est possible et facile de générer notre livrable

- Deux générations de livrables partant d’une meme version génèrent le “même” livrable!

Que signifie “reproductible” ?

- Il faut que notre processus de génération de livrable, (le build) soit entièrement déterministe.

- Il faut qu’en fonction d’un jeu de paramètres, le résultat du build soit même le “même”.

- Il en va de même pour l’environnement ou notre programme est exécuté.

- Notre environnement de production

Quels sont les paramètres de notre livraison ?

- Le code: Dans quelle version est-il? Est-il fonctionnel? Est-ce qu’il est sauvegardé?

- Les dépendances de notre code: Toutes les libraires utilisés dans notre application.

- Les outils de génération de livrables: Quel compilateur et dans quelle version?

- L’environnement d’exécution cible: Node 22 ou Node 23? Quelle version de PostgreSQL? Quel OS/Architecture CPU? Quel Navigateur?

- Le processus de livraison lui même: Dans quelle mesure la procédure de génération est elle répétable et respectée?

Risques encourus?

- Ne pas etre capable de livrer!

- 😡 Dans le meilleur des cas, votre livrable ne marche pas du tout.

- 🤡 Dans certains cas votre livrable va casser sans explication facile et seulement sur la production du client les jours impairs d’une année bisextile.

- Allez reproduire et débugger!

- 😱 Livrer votre application va devenir une angoisse permanente

- 😱😭🔥☠️ Vous livrez une CVE ou un malware, avec un accès direct a votre base de données.

On en est où la dedans? (1/2)

- Le code

- ✅ On vient de mettre en place git. On sait identifier une version par un hash de commit.

- ❌ On ne sait pas vraiment dire si l’application “fonctionne” ou pas.

- Les dépendances de notre code

- ❌ On ne sait ni les récupérer, ni les contrôler.

- Les outils permettant de générer notre livrable

- ❌ Typescript 5 est indiqué dans la documentation fournie mais c’est tout

On en est où la dedans? (2/2)

- L’environnement cible:

- ❌ Aucune version de node indiquée.

- ❌ On sait que l’on à besoin de Postgres et Postgis

- Le processus de livraison lui même:

- ❌ Nous n’avons encore rien défini

Quelles solutions ? (1/2)

- Le code

- ➡️ Solution (pour garantir une bonne utilisation): L’analyse statique (le lint)

- ➡️ Solution (pour savoir si il fonctionne): les tests automatisés

- ➡️ Solution (pour garantir qu’il fonctionne à chaque changement): l’intégration continue (CI)

- Les dépendances du code

- ➡️ Solution: Mise en place d’un outil de gestion et d’audit des dépendances

- Les outils de génération du code:

- ➡️ Solution: Mise en place d’un processus automatisé de génération de livrable s’expécutant dans un environment controllé

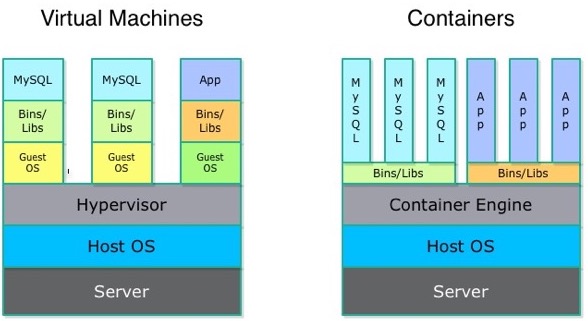

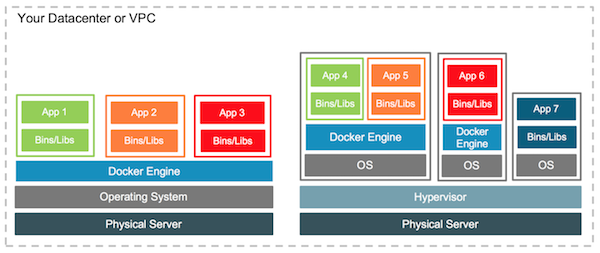

Quelles solutions ? (2/2)

- L’environnement cible:

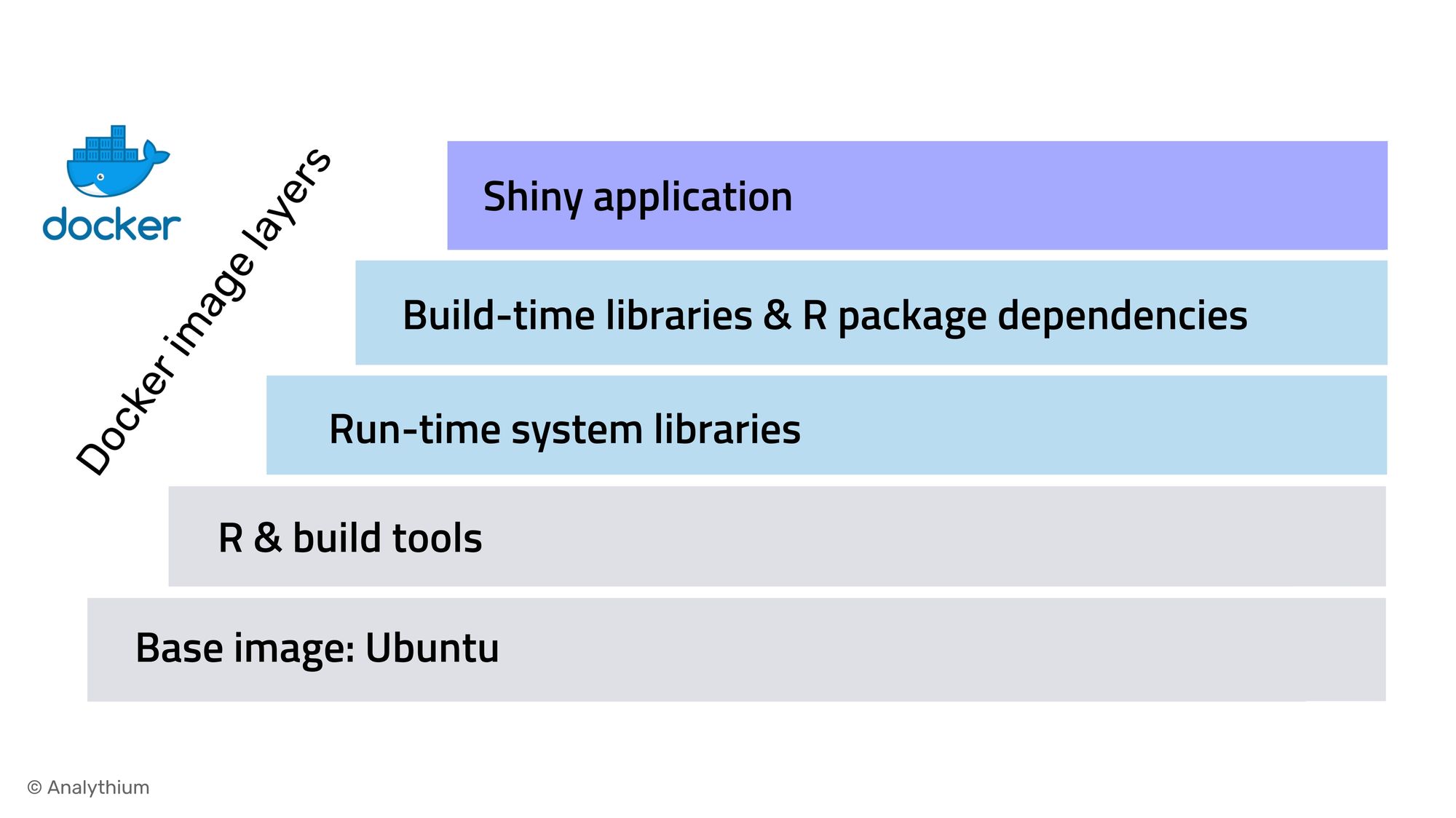

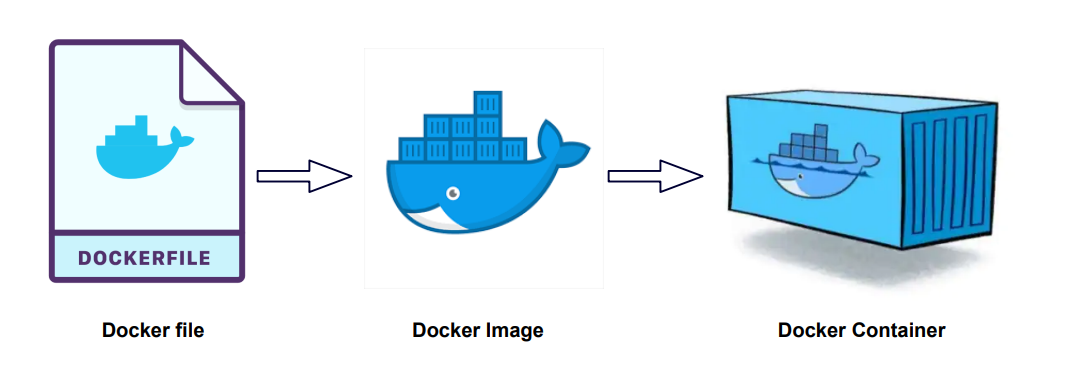

- ➡️ Solution: Utilisation d’outils de packaging (Docker) pour notre application et son environment cible

- Le processus de livraison lui même:

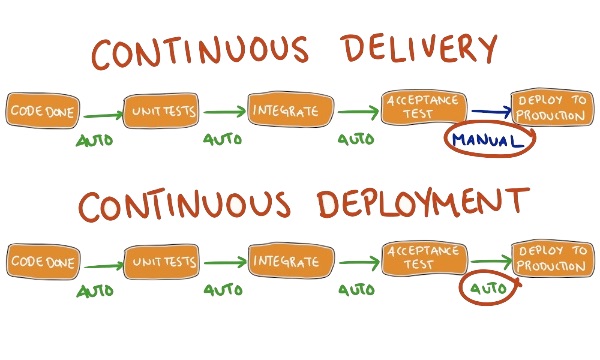

- ➡️ Solution: définir un cycle de vie et en déduire un processus de livraison

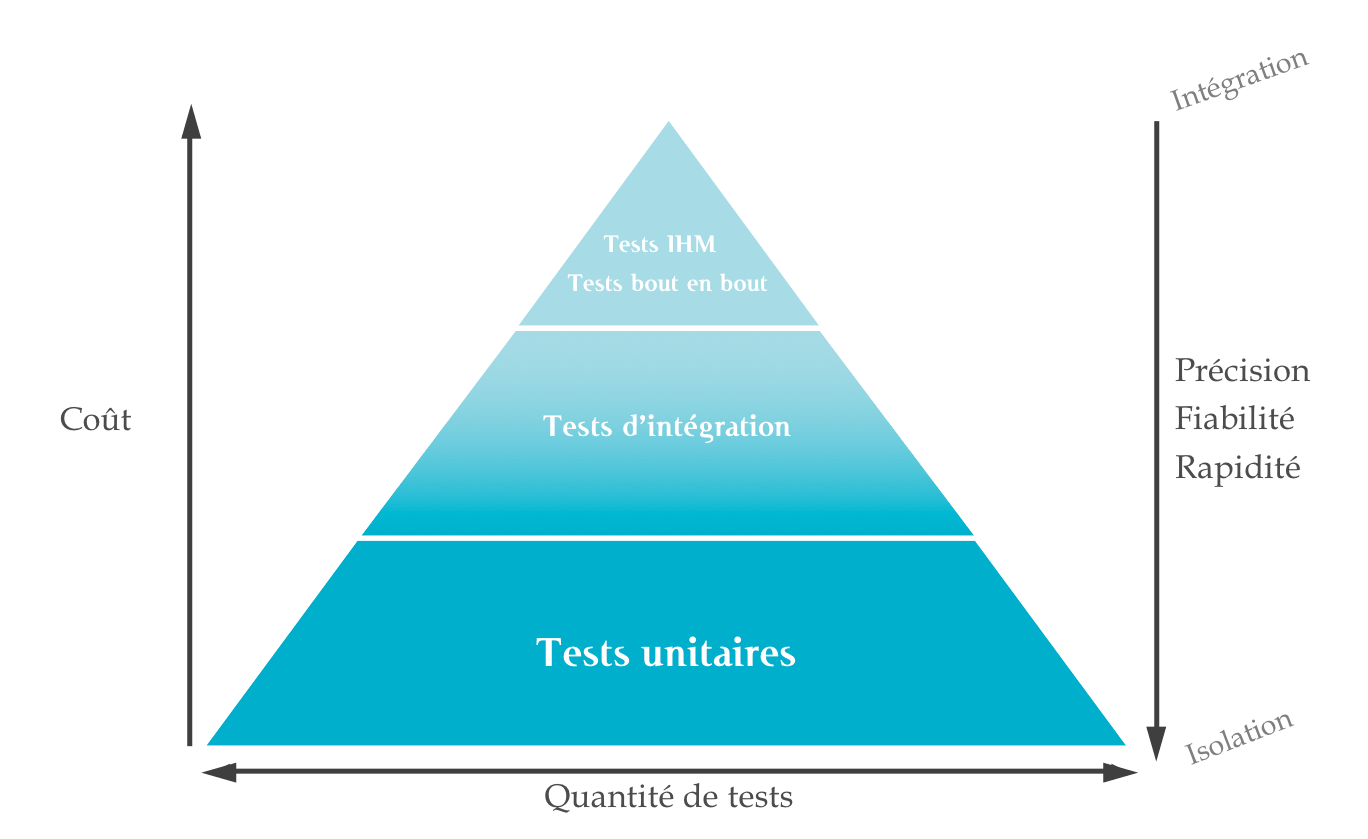

Les grandes étapes de la génération de notre livrable

build: Compilation de l’applicationlint: Analyse statique de code pour détecter des problèmes ou risquestest: Exécution de la suite de tests automatiséespackage: Création du livrablerelease: Livraison du livrable

Checkpoint 🎯

Notre première étape va etre de faire en sorte de pouvoir lancer le serveur dans notre environment de développement.

Cela sigifie:

- Installer toutes les dépendances nécesaires pour la génération et l´exécution de notre code

- Générer du code exécutable (appeler

tsc)

La Gestion de Dépendances

Pourquoi réutiliser du code et des outils?

- 🧱 L’informatique moderne est un assemblage de briques logicielles

- ⚙️ … chacune des briques étant infiniment complexe

- Ex: TLS, PostgresSQL, Linux, Firefox…

- 🤔 Il est difficilement envisageable de démarrer un projet sans réutiliser des briques logicielles.

- 🧘 Cela permet de concentrer son effort de développement sur ce qui apporte de la valeur.

- ➡️ Dans notre cas, notre métier est la gestion de véhicules, pas l’implémentation d’une pile réseau et d’un serveur HTTP.

⚠️ Ajouter une dépendance n’est pas un acte anodin ⚠️

- Si votre dépendance ne fonctionne plus ou est compromise, votre livrable sera impactée

- Attention à ne pas rajouter une dépendance trop grosse pour n’utiliser qu’une petite fonctionnalité!

- Attention aux dépendances de vos dépendances 😱

- Quelques règles d’usage:

- Vérifier que votre dépendance est activement maintenue? (date du dernier commit, existence d’une communauté autour)

- 👀 le code. Est-ce que vous le comprenez? Est-ce que vous pourriez le debugger ou le faire vous même?

Dépendre de librairies externes pose une quantité de problèmes!

- Comment récupérer l’intégralité du code dont on à besoin?

- Comment maintenir à jour ce code?

- Comment s’assurer qu’il n’a pas été modifié?

- Comment garantir la reproductibilité de ce processus?

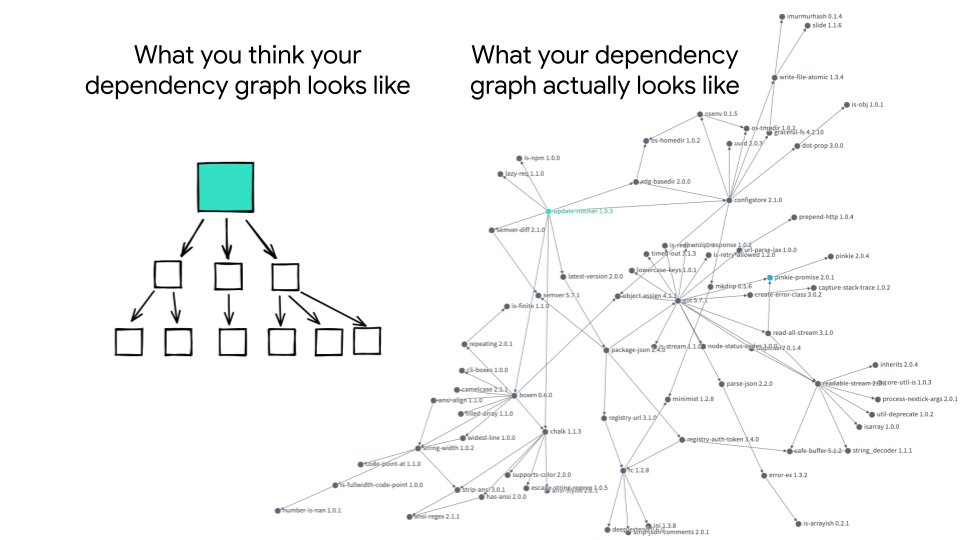

Mais le pire, c’est que c’est un problème récursif! Nos dépendances ont aussi des dépendances!

Un peu de terminologie

- Une dépendance est une librairie de code externe ou un outil qui fournit une fonctionnalité.

- On distingue deux types de dépendances:

- dépendance directe: référencée directement par notre application

- dépendance transitive: référencée par une des librairies dont l’application dépends

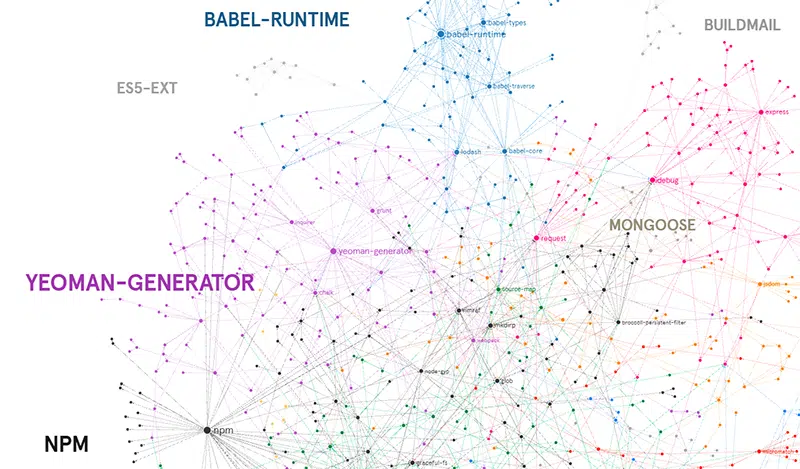

Comment gérer ses dépendances?

- On introduit un outil de gestion de dépendances

- Permets au développeur de définir une liste de dépendances en fixant ou en plaçant une contrainte de version (ex <= 4.3.0)

- Cela permet de construitruire un arbre de dépendances

- Télécharge toutes les dépendances dans l’environment d’exécution et les mets à disposition de l’application.

Comment cela fonctionne avec Javascript?

NPM kesako?

- Node Package Manager

- Package Manager et infrastructure de distribution de paquets (registry)

- Gère aussi bien les dépendances de code que les outils

- Des alternatives existent (yarn et pnpm)

Du coup c’est quoi un paquet?

- Un fichier ou un répertoire décrit par un fichier

package.json - Un paquet peut mettre à disposition:

- Un module Javascript / Typescript

- Des scripts exécutables

- Pour lancer un script il vous faut utiliser la commande

npx <script>

- Pour lancer un script il vous faut utiliser la commande

🎓 Exercice: Initialisez un nouveau paquet NPM

- Dans le répertoire

/workspace/vehicle-server- Lancez la comande

npm init - Répondez aux questions posées

- Lancez la comande

- Observez ensuite le fichier généré

Le fichier package.json

- Fichier décrivant un

paquetnpm - Contient des métadonées a propos du paquet

- Et surtout, la liste des paquets dont dépends notre projet!

- ℹ️ Ses dépendances directes

Zoom sur les dépendances

npm distingue quatre types de dépendances:

- Dépendances de prodution: nécessaires a l’exécution du projet

- Dépendances de développement: nécessaires au développement du projet (option

--save-dev) - Dépendances de peers: contraint des versions entres packages (option

--save-peers) - Dépendances optionelles: dépendances non nécessaires mais pouvant ajouter des foncitonalités (option

--save-optional)

⚠️ Selon où vous utilisez npm, vous n’avez pas besoin de toutes les dépendances ⚠️

Comment NPM gère les dépendances transitives?

- Certains paquets (la majorité) ont aussi des dépendances, qui deviennent indirectement des dépendances de notre projet

- npm télécharge chacune des dépendances de chacun des parquets et les écrit dans

node_modules- Oui la taille du répertoire

node_modulesest un problème 😭

- Oui la taille du répertoire

- ☢️ Cela signifie que plusieurs versions d’une meme paquet peut etre présent dans l’arbre de dépendance d’un projet!

Visualiser l’arbre de dépendances

npm lspermets de lister les dépendances d’un projet (--allaffiche tout l’arbre de dépendance!)- Ce site permets d’afficher l’arbre de dépendance d’un paquet public NPM

🎓 Exercice: Ajoutez Typescript comme dépendance

- Il nous faut typescript d’installé pour pouvoir générer du Javascript

- Le package se trouve ici

- Quels sont les fichiers / répertoires changés ou créés par npm? Quels sont leur roles?

✅ Exercice: Ajoutez Typescript comme dépendance

npm install --save-dev typescript- ⚠️

-Dou--save-dev: Typescript n’est pas utile a l´exécution!

- ⚠️

- Une section

devDependenciesest ajoutée aupackage.jsontypescriptest listé avec la version^5.6.3

- Un mystérieux fichier

package-lock.jsonest aussi généré! - Enfin un répertoire

node_modulesest créé content le code du packagetypescript!

Configurer le Compilateur Typescript

tsc nécessite un fichier de configuration tsconfig.json pour fonctionner.

Créez ce fichier et ajoutez le contenu suivant:

{

"compilerOptions": {

"target": "es2020", /* Set the JavaScript language version for emitted JavaScript and include compatible library declarations. */

"module": "commonjs", /* Specify what module code is generated. */

"outDir": "dist", /* Specify an output folder for all emitted files. */

"esModuleInterop": true, /* Emit additional JavaScript to ease support for importing CommonJS modules. This enables 'allowSyntheticDefaultImports' for type compatibility. */

"forceConsistentCasingInFileNames": true, /* Ensure that casing is correct in imports. */

"strict": true, /* Enable all strict type-checking options. */

"skipLibCheck": true /* Skip type checking all .d.ts files. */

}

}

Versions

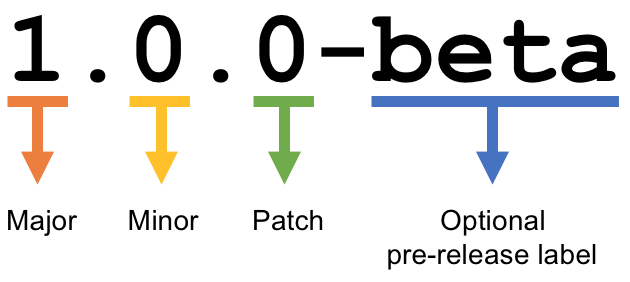

NPM suit un standard pour exprimer des versions appelé semantic versioning

Un changement ne changeant pas le périmètre fonctionnel incrémente le numéro de version patch.

Par exemple: une correction de bug

Un changement changeant le périmètre fonctionnel de façon rétrocompatible incrémente le numéro de version mineure.

Par exemple: L’ajout d’une nouvelle fonction dans une librairie

Un changement changeant le périmètre fonctionnel de façon rétrocompatible incrémente le numéro de version mineure.

Par exemple: L’ajout d’une nouvelle fonction dans une librairie

Un changement changeant le périmètre fonctionnel de façon non rétrocompatible incrémente le numéro de version majeure.

Par exemple: Le retrait d’une fonction dans une librairie

On résume

- Changer de version mineure ne devrait avoir aucun d’impact sur votre code.

- Changer de version majeure peut nécessiter des adaptations.

Mais tout ça dépends du bon vouloir et de la rigeur des mainteneurs 😅

Contraindre des versions avec NPM

typescript est listé avec la version ^5.6.3 (notez le ^), qu’est ce que cela signifie?

NPM liste en dépendance des ranges de versions, cela signifie:

^: Toutes les versions ayant la meme version majeure- exemple:

5.6.4,5.9.10,5.48.4

- exemple:

~: Toutes les versions ayant la meme version mineure- exemple:

5.6.4,5.6.5,5.6.6

- exemple:

>,>=: Toutes les version superieures a la version indiquée- exemple:

5.6.4,6.4.3etc…

- exemple:

5.6.4: Un range d’une valeur unique… on fixe la version

npm install permets de forcer l’installation d’un paquet dans une certaine version

npm install is-true@4.3.0 # <- installera is true avec la contrainte ^4.3.0

Comment NPM fonctionne?

- Prends les dépendances listées dans un fichier

package.json - Résouds toutes les dépendances (transitives et directes) vers la plus grande version autorisée et disponible

- Télécharge l’arbre de dépendance et l’écrit dans le répertoire

node_modules

Vous voyez un problème?

Que se passe t’il si, entre deux installations, une nouvelle version autorisée par la liste des dépendances est publiée?

⚠️ L’installation des paquets NPM n’est pas reproductible!

- Les paquets installés peuvent changer d’une installation l’autre!

- Les contraintes de versions exprimées ne suffisent pas “figer” un arbre de dépendance!

- On peut figer ses dépendances directes, mais aucune garantie que les dites dépendances feront de même avec les leurs!

- 😭 Cela peut introduire des problèmes!

- 💀 … ou pire être un vecteur d’attaque !

Solution: le fichier package-lock.json

- C’est une photo qui capture l’arbre de dépendances complet et permets á NPM d’installer exactement le même arbre!

- Il capture pour chaque dépendance:

- La

versionexacte utilisée - L’URL de téléchargement du paquet (

resolved) - Une somme de contrôle de l’archive téléchargée (

integrity), qui permet de vérifier que l’archive téléchargée n’est pas altérée

- La

🎓 Que continent votre fichier package-lock.json? Quelle est la particularité du paquet typescript?

🎓 Exercice: Installez les dépendances nécessaires pour transpiler et exécuter le projet!

- Pour compiler:

- Il nous faut les définitions de types des libraries JS utilisées (paquets

@types/xxxx) - Les définitons de types de NodeJS

- Il nous faut les définitions de types des libraries JS utilisées (paquets

- Pour exécuter:

- Faites attention a bien différencier les dépendances d’exécution, des dépendances de développement

Voici les commandes pour compiler et lancer le serveur

# Lancer le serveur de base de données (si il n'existe pas déja!)

docker run -d -name vehicle-database -e POSTGRES_USER=vehicle -e POSTGRES_PASSWORD=vehicle -e POSTGRES_DB=vehicle -p 5432:5432 postgis/postgis:16-3.4-alpine

# Compile le serveur de Typescript vers Javascript

npx tsc

# Lance le serveur javascript

node dist/index.js

# Vous pouvez ensuite rejouer les requètes du README!

✅ Solution: Installez les dépendances nécessaires pour transpiler et exécuter le projet!

npm install --save-dev @types/express @types/node @types/pg

npm install express@5.0.1 pg

rm -rf dist/

npx tsc

node dist/index.js

(Bonus) Combien de dépendances ont été installées au total? 😱

Audit de dépendances

- Du coup cette petite aventure nous aura fait installer 117 paquets!

- Il est virtuellement impossible d’aller auditer soi même toutes ces dépendances!

- npm fournit une commande

auditqui permets de détecter (voir même de corriger automatiquement) des problèmes de sécurité sur l’arbre de dépendances!- ⚠️ Toutes les failles de sécurité ne se valent pas (exemple )

- ⚠️ Cela n’empêche pas d’aller mettre son nez dans le code de certaines de vos dépendances

Scripts NPM

NPM permets de définir dans le fichier package.json des scripts exécutables via la commande npm run <script-name>

Cela permets de “normaliser” les commandes utilisées pour travailler avec un projet

// package.json

{

// ...

"scripts": {

"build": "rm -rf ./dist && tsc",

"start": "npm run build && node dist/index.js",

"start-db": "docker container run -d -name vehicle-database -e POSTGRES_USER=vehicle -e POSTGRES_PASSWORD=vehicle -e POSTGRES_DB=vehicle -p 5432:5432 postgis/postgis:16-3.4-alpine",

"stop-db": "docker container rm -f vehicle-database"

},

// ...

}

🎓 Ajoutez ces scripts a votre fichier package.json, vous pourrez utiliser ensuite les commandes suivantes

npm run start-db

npm run start

npm run stop-db

Checkpoint 🎯

- Nous avons vu les défis de la gestion de dépendance et le fonctionnement de NPM!

- Un paquet npm sans

package-lock.jsonn’est pas reproductible! - Nous sommes maintenant capable de compiler et d’exécuter notre projet!

- C’est une étape importante, créez donc un commit pour sauvegarder ça!

Mettre son code en sécurité

Une autre petite histoire

Votre dépôt est actuellement sur votre ordinateur.

- Que se passe t’il si :

- Votre disque dur tombe en panne ?

- On vous vole votre ordinateur ?

- Vous échappez votre tasse de thé / café sur votre ordinateur ?

- Une météorite tombe sur votre bureau et fracasse votre ordinateur ?

C’est arrivé à la personne qui a écrit ces slides…

Comment éviter ça?

- Répliquer votre dépôt sur une ou plusieurs machines !

- Git est pensé pour gérer ce de problème

Gestion de version décentralisée

- Chaque utilisateur maintient une version du dépôt local qu’il peut changer à souhait

- Ils peuvent “pousser” une version sur un dépôt distant

- Un dépôt local peut avoir plusieurs dépôts distants.

Centralisé vs Décentralisé

Cela rends la manipulation un peu plus complexe, allons-y pas à pas :-)

🎓 Exercice: Créer un dépôt distant

Consulter l’historique de commits

Dans votre workspace

# Liste tous les commits présent sur la branche main.

git log

Associer un dépôt distant (1/2)

Git permet de manipuler des “remotes”

- Image “distante” (sur un autre ordinateur) de votre dépôt local.

- Permet de publier et de rapatrier des branches.

- Le serveur maintient sa propre arborescence de commits, tout comme votre dépôt local.

- Un dépôt peut posséder N remotes.

Associer un dépôt distant (2/2)

# Liste les remotes associés a votre dépôt

git remote -v

# Ajoute votre dépôt comme remote appelé `origin`

git remote add origin https://<URL de votre dépôt>

# Vérifiez que votre nouveau remote `origin` est bien listé a la bonne adresse

git remote -v

Publier une branche dans sur dépôt distant

# git push <remote> <votre_branche_courante>

git push origin main

Que s’est il passé ?

gita envoyé la branchemainsur le remoteorigin- … qui à accepté le changement et mis à jour sa propre branche main.

gita créé localement une branche distanteorigin/mainqui suis l’état demainsur le remote.- Vous pouvez constater que la page github de votre dépôt affiche le code source

Refaisons un commit !

git commit --allow-empty -m "Yet another commit"

git push origin main

Branche distante

- Dans votre dépôt local, une branche “distante” est automatiquement maintenue par git

- Elle suit le dernier état connu de la branche sur le remote.

- Pour voir toutes les branches distantes

git branch -a

- Pour mettre a jour les branches distantes depuis le remote:

git fetch <nom_du_remote>

# Lister toutes les branches y compris les branches distances

git branch -a

# Notez que est listé remotes/origin/main

# Mets a jour les branches distantes du remote origin

git fetch origin

# Rien ne se passe, votre dépôt est tout neuf, changeons ça!

Créez un commit depuis GitHub directement

- Cliquez sur le bouton éditer en haut à droite du “README”

- Changez le contenu de votre README

- Dans la section “Commit changes”

- Ajoutez un titre de commit et une description

- Cochez “Commit directly to the main branch”

- Validez

GitHub crée directement un commit sur la branche main sur le dépôt distant

Rapatrier les changements distants

# Mets à jour les branches distantes du dépôt origin

git fetch origin

# La branche distante main a avancé sur le remote origin

# => La branche remotes/origin/main est donc mise a jour

# Ouvrez votre README

code ./README.md

# Mystère, le fichier README ne contient pas vos derniers changements?

git log

# Votre nouveau commit n'est pas présent, AHA !

Branche Distante VS Branche Locale

Le nouveau commit à été rapatrié

Cependant il n’est pas encore présent sur votre branche main locale

# Merge la branch distante dans la branche locale.

git merge origin/main

Vu que votre branche main n’a pas divergé (== partage le même historique) de la branche distante, git merge effectue automatiquement un “fast forward”.

Updating 1919673..b712a8e

Fast-forward

README.md | 1 +

1 file changed, 1 insertion(+)

Cela signifie qu’il fait “avancer” la branche main sur le même commit que la branche origin/main

# Liste l'historique de commit

git log

# Votre nouveau commit est présent sur la branche main !

# Juste au dessus de votre commit initial !

Et vous devriez voir votre changement dans le ficher README.md

Git(Hub|Lab|tea|…)

Un dépôt distant peut être hébergé par n’importe quel serveur sans besoin autre qu’un accès SSH ou HTTPS.

Une multitudes de services facilitent et enrichissent encore git: (GitHub, Gitlab, Gitea, Bitbucket…)

=> Dans le cadre du cours, nous allons utiliser GitHub.

git + GitHub = superpowers!

- GUI de navigation dans le code

- Plateforme de gestion et suivi d’issues

- Plateforme de revue de code

- Intégration aux moteurs de CI/CD

- And so much more…

Intégration Continue (CI)

Continuous Integration doesn’t get rid of bugs

But it does make them dramatically easier to find and remove.

Martin Fowler

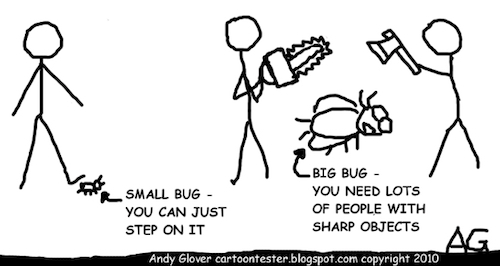

Pourquoi faire de L’Intégration Continue ?

But : Détecter les fautes au plus tôt pour en limiter le coût

Source : http://cartoontester.blogspot.be/2010/01/big-bugs.html

Qu’est ce que l’Intégration Continue ?

Objectif : que l’intégration de code soit un non-évènement

- Construire et intégrer le code en continu

- Le code est intégré souvent (au moins quotidiennement)

- Chaque intégration est validée de façon systématique et automatisée

- On joue une collection de vérifications qui atteste que le changement ne casse pas l’existant

- compilation, tests, lint etc…

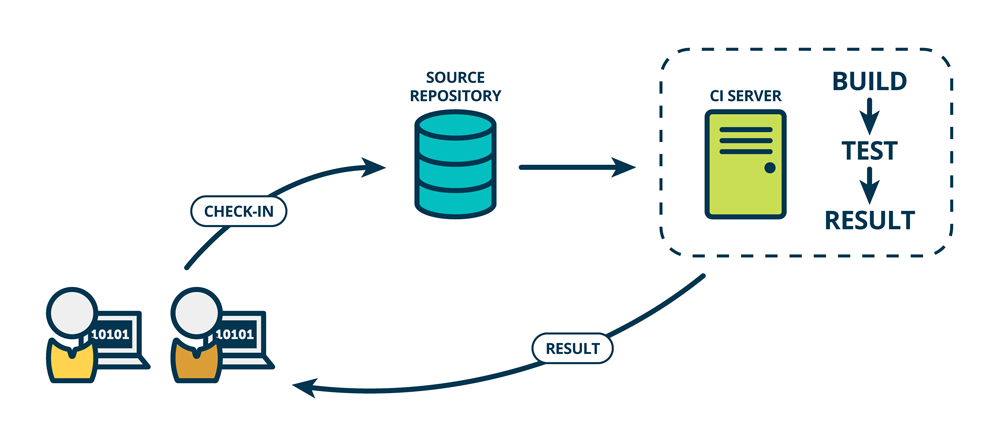

Et concrètement ? 1/2

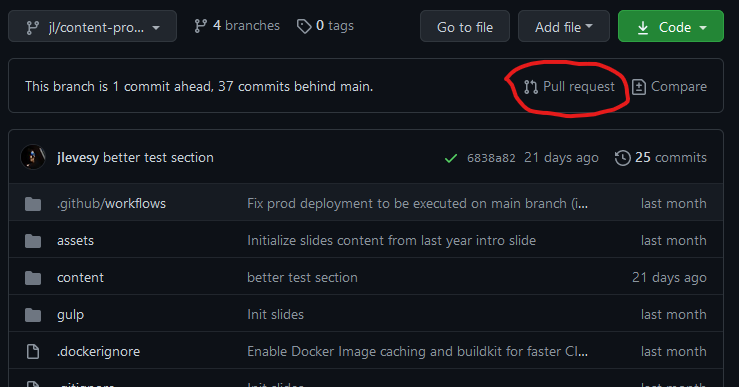

- Un•e dévelopeu•se•r ajoute du code/branche/PR :

- une requête HTTP est envoyée au système de “CI”

- Le système de CI compile et teste le code

- On ferme la boucle : Le résultat est renvoyé au dévelopeu•se•r•s

Et concrètement ? 2/2

Quelques moteurs de CI connus

- A héberger soit-même : Jenkins , GitLab CI , Drone CI CDS …

- Hébergés en ligne : Travis CI , Semaphore CI , CircleCI , Code Fresh , GitHub Actions

GitHub Actions

GitHub Actions est un moteur de CI/CD intégré à GitHub

- ✅ : Très facile à mettre en place, gratuit et intégré complètement

- ❌ : Utilisable uniquement avec GitHub, et DANS la plateforme GitHub

Concepts de GitHub Actions

- Sur un évènement déclencheur

- GitHub crée un ou plusieurs environment d’exécution (Runner)

- Et exécute une ou plusieurs suites d’étapes

- Enfin la (les) runner(s) sont détruits une fois toutes les étapes exécutées

Concepts de GitHub Actions - Step 1/3

Concepts de GitHub Actions - Step 2/3

Une Step (étape) est une tâche individuelle à faire effectuer par le CI :

- Par défaut c’est une commande à exécuter - mot clef

run - Ou une “action” (quel est le nom du produit déjà ?) - mot clef

uses- Réutilisables et partageables !

steps: # Liste de steps

# Exemple de step 1 (commande)

- name: Say Hello

run: echo "Hello ENSG"

# Exemple de step 2 (une action)

- name: 'Login to DockerHub'

uses: docker/login-action@v1 # https://github.com/marketplace/actions/docker-login

with:

username: ${{ secrets.DOCKERHUB_USERNAME }}

password: ${{ secrets.DOCKERHUB_TOKEN }}

Concepts de GitHub Actions - Step 3/3

Une Step peut avoir des outputs

steps:

- name: "Install Node"

uses: actions/setup-node@v4

id: setup_node

with:

node-version: '22.04'

- name: "Echo installed version"

run: |

echo "${{steps.setup_node.outputs.node-version}}"

Concepts de GitHub Actions - Job 1/2

Concepts de GitHub Actions - Job 2/2

Un Job est un groupe logique de steps :

- Enchaînement séquentiel de steps

- 1 Job == 1 Runner créé

- Regroupement logique :

- Exemple : “compiler puis tester le résultat de la compilation”

jobs: # Map de jobs

build: # 1er job, identifié comme 'build'

name: 'Build Slides'

runs-on: ubuntu-22.04 # cf. prochaine slide "Concepts de GitHub Actions - Runner"

steps: # Collection de steps du job

- name: 'Build the JAR'

run: mvn package

- name: 'Run Tests on the JAR file'

run: mvn verify

deploy: # 2nd job, identifié comme 'deploy'

# ...

Concepts de GitHub Actions - Runner

Un Runner est un serveur distant sur lequel s’exécute un job.

- Mot clef

runs-ondans la définition d’un job - Défaut : machine virtuelle Ubuntu dans le cloud utilisé par GitHub

- D’autres types sont disponibles (macOS, Windows, etc.)

- Possibilité de fournir son propre serveur

Concepts de GitHub Actions - Workflow 1/2

Concepts de GitHub Actions - Workflow 2/2

Un Workflow est une procédure automatisée composée de plusieurs jobs, décrite par un fichier YAML.

- On parle de “Workflow/Pipeline as Code”

- Chemin :

.github/workflows/<nom du workflow>.yml - On peut avoir plusieurs fichiers donc plusieurs workflows

.github/workflows

├── ci-cd.yaml

├── bump-dependency.yml

└── nightly-tests.yaml

Concepts de GitHub Actions - Évènement 1/2

Concepts de GitHub Actions - Évènement 2/2